Resumen:

En este ensayo analizamos el tipo paradigmático de máquina que está en la base de la semejanza que se hegemoniza actualmente en las relaciones entre cerebro y máquina. Así, presentamos cómo se construyeron los elementos fundamentales de operación de la máquina digital: las computadoras, la información y codificación digital como parte de un mismo programa de uniformización y universalización de la lógica binaria digital. Mostramos, en continuidad, cómo ese programa está conformando una comprensión reduccionista de los procesos de individuación del cerebro y también de las máquinas. Por fin, valiéndonos de la propuesta alternativa de información como procesualidad de Gilbert Simondon y de la teoría del cerebro relativístico de Nicolelis y Cicurel, presentamos las limitaciones del paradigma de la máquina digital y los caminos abiertos para otras comprensiones de los procesos de individuación del cerebro y de las máquinas.

Palabras clave: Simondon; cerebro; individuación; máquina; información digital.

Abstract:

In this essay we analyze the paradigmatic type of machine that supports the currently hegemonic similarity in the relations between the brain and the machine. Thus, we present how the fundamental elements of the functionality of the digital machine were built: computers, information and digital code as part of the same standardization and universalization program of digital binary logic. We show, in continuity, how that program is building a reductionist understanding of the brain’s and machine’s processes of individuation. Finally, through the Simondon’s alternative information proposal, as processuality, and through the relativistic brain theory of Nicolelis and Cicurel, we present the limitations of the digital machine’s paradigm and the open ways for other understandings of the brain’s and machine’s processes of individuation.

Key-words: Simondon; brain; individuation; machine; digital information.

El pensamiento pseudo-científico hace un amplio uso de la semejanza, a veces incluso de la semejanza de vocabulario, pero no hace uso de la analogía. Así, el pensamiento pseudo-científico produce un verdadero derroche de imágenes y de palabras-claves: onda, rayo… Estas palabras solo recubren imágenes confusas, apenas capaces de asegurar una semejanza afectiva entre la propagación de una alteración mecánica en un fluido y la de un campo electromagnético sin soporte físico. Muy recientemente, se ha podido notar la confusión entre dos consonancias vecinas: la del «servomecanismo» y la del «cerebro», en el sentido en que se puede llamar cerebro a un centro de pilotaje automático o de autorregulación: el sentido de «esclavo» y de «órgano de comando» son mezclados en la semejanza afectiva de todo lo que es «de orden cibernético», y emplea relevos y tubos al vacío o tiratrones.

Gilbert Simondon. “Allagmática”.[1]

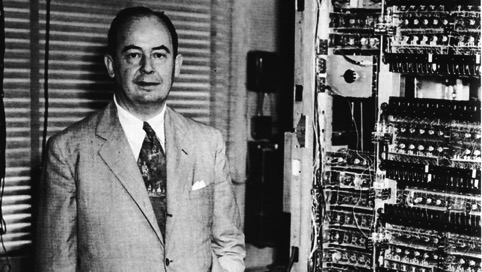

La comparación entre el cuerpo y la máquina, o después, entre esta y el cerebro, tiene una larga trayectoria en la historia de las ciencias y de la filosofía. De los autómatas cartesianos al cerebro como órgano de comando o pilotaje y como sistema general de control o autorregulación de los cibernéticos, una gran ficción nos seduce afectivamente a la semejanza irrefrenable entre cerebro y máquina. Que John Von Neumann tenga perfeccionado el prototipo de Turing de la computadora por medio de los estudios de las redes neuronales de McCulloch y Pitts, creando la base de lo que hoy comprendemos como una computadora, solo confirma y da fuerza a la genealogía de esa semejanza, construyendo una teleología casi inexorable.

Ahora, por ejemplo, entre las reflexiones de Miguel Benasayag sobre El cerebro aumentado, el hombre disminuido, texto en el que propone que la posibilidad de un hombre nuevo ―alejado de la vieja figura del hombre moderno de la que nos habló Foucault― se dibuja en el horizonte del nuevo siglo, en la hibridación humano-biología-artefacto, en la cual “[…] el cerebro se ha tomado a sí mismo como objeto de estudio”[2] y las reflexiones de Brian Christian sobre El humano más humano en el que se propone participar del Premio Loebner —una de las versiones actuales más contundente del Test de Turing— no para probar o refrenar la idea contenida en la pregunta “¿las máquinas pueden pensar?”, sino para ganar el premio de “humano más humano” y probar la singularidad humana, parece haber un acuerdo tácito de que, en la semejanza cerebro-máquina o humano-máquina, lo que hay que revisar es lo que comprendemos por cerebro o por humano. Eso, casi como un intento desesperado de salvar de la digitalización total el pensamiento, el cuerpo y la vida ética de los individuos, de la equivalencia perfecta de la máquina como ser gobernable y programable en contraposición con el humano, como ser indeterminado y libre.

Pero, en los últimos años, mientras Watson vencía el programa de preguntas Jeopardy, la robot Sophia daba entrevistas y coqueteaba con Will Smith y la IBM presentaba su Project Debater con una computadora que superaba, en muchos puntos, a entrenados retóricos y polemistas en la argumentación, Miguel Nicolelis, el neurocientista responsable de la creación del exoesqueleto que hizo que Juliano Pinto, un parapléjico, pudiera realizar el disparo inicial del partido de apertura de la Copa del Mundo 2014, caminaba en el sentido opuesto para reinventar la comprensión del cerebro, transformando el concepto de lo que entendemos por máquina.

ROBOT SOFÍA

Tal vez, sea aún más interesante que criticar o revisar la idea del cerebro que muchos científicos y filósofos tienen propuesta en la semejanza cerebro-máquina, la idea de rencontrarnos con otro concepto de máquina de los que las analogías con el cerebro nos pueden permitir. En ese sentido, este ensayo no se propone una crítica de la semejanza cerebro-máquina, sino una amplificación de la comprensión de la individuación del cerebro, desde una modulación de su analogía con la máquina.

Por tanto, veremos en este ensayo, en primera instancia, cómo se conformó la semejanza cerebro-máquina desde la postulación de un programa común, existente en ambos como codificación digital. Después veremos que la equivalencia postulada entre el cerebro y la máquina, como dos individuos que se organizan y que pueden ser controlados por medio de la información digital, es lo que permitió que alguien como Ray Kurzweil ―director de ingeniería de Google y tal vez uno de los más famosos gurús de la Inteligencia Artificial― pudiera proponer en su libro Cómo crear una mente que en pocos años las máquinas podrán simular un cerebro y que podremos hacer incluso el download del cerebro en una máquina. Presentaremos, entonces, en líneas generales cómo se armó la comprensión de la información digital, para después mostrar cómo el filósofo Gilbert Simondon propuso una comprensión alternativa de la información como la procesualidad. A continuación, presentaremos la diferencia entre estas dos comprensiones de la información desde tres figuras de máquinas digitales en sus limitaciones y en sus amplificaciones posibles.

La información y las máquinas de codificación digital

La semejanza entre cerebro y máquina, desde el comienzo, esconde una generalización problemática. La semejanza no es postulada desde un modelo general o abstracto de la máquina, sino desde un tipo bastante específico de máquina que, por su importancia actual, se transformó prácticamente en un sinónimo de todas: la computadora digital. Recuperemos brevemente la historia de cómo la computadora se transformó en el paradigma para la máquina y, el digital, el paradigma para la semejanza entre todos los seres. Curiosamente veremos que el recurrido de la ciencia de la computación o informática empieza con un alejamiento radical de la semejanza entre cerebro y máquina, en la búsqueda de la superación de las limitaciones humanas de cálculo, para regresar a la búsqueda de aproximación y equivalencia entre cerebro-máquina en la Inteligencia Artificial de los Watsons y Sophias que prometen simular cerebros humanos.

En el comienzo del siglo XX, la palabra “computadora” designaba seres humanos que laboraban haciendo cálculos y análisis numéricos. No por casualidad, Alan Turing —uno de los padres de la computación— en su ensayo fundamental Sobre los números computables, con su aplicación al Eitscheidungsproblem (1936) propuso lo que llegarían a ser las computadoras digitales por medio de una comparación con las computadoras humanas.[3]

En ese ensayo, Turing se propuso un experimento mental que consistía en imaginar una máquina abstracta que pudiera ejecutar cualquier tarea y resolver cualquier problema que pudiera ser reducido a símbolos partiendo de un conjunto finito de instrucciones (algoritmos) y por medio de cálculos. En resumen, la idea básica de Turing era que cualquier símbolo podría ser traducido al lenguaje binario (digital) de 0 y 1, y que, introducido en una máquina programada, desde un conjunto de instrucciones, se podrían leer esos símbolos realizando operaciones de computación, excediendo, de este modo, la capacidad de cálculo de las computadoras humanas.

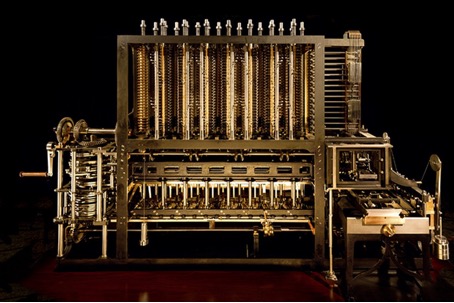

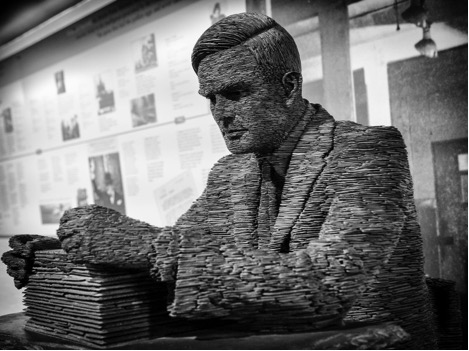

La idea de Turing tenía sus precursores. En 1804, Joseph-Marie Jacquard inventó un dispositivo que se transformaría en el prototipo de las computadoras del siglo XX: el telar mecánico que funcionaba del siguiente modo: una misma máquina de telar podría ser programada por medio de cartones perforados para producir todo tipo de imágenes, es decir, design de tejidos. Así, mientras el telar mecánico revolucionaba la producción textil, de la manufactura artesanal a la producción maquínica industrial, él también, a la vez, señalaba el camino para las máquinas digitales o el germen de la digitalización. Ese camino fue desarrollado, en el siglo XIX todavía, por otros dos precursores, Charles Babbage y Ada Lovelace ―la primera programadora de la historia de la computación―. Babbage y Lovelace trabajaban en la hipótesis de construcción de una máquina, a la que nombraron Máquina Analítica, que pudiera operar representando símbolos de modo más abstracto de lo que hacia la máquina de Jacquard. Como propuso Lovelace: “Podemos decir que la Máquina Analítica teje padrones algébricos, así como el telar de Jacquard teje flores y hojas”.[4]

Turing supo valerse de esas ideas precursoras proponiendo una máquina que estaría habilitada para leer (computar) todo tipo de símbolos —de los padrones de la tejeduría a los algebraicos— almacenando en su programa de base no solo esos padrones, sino también las propias instrucciones (algoritmos que determinan la habilidad de computar) de otras máquinas. Turing imaginaba que cada computadora digital construida con un programa (conjunto de instrucciones) podría ser también leída por otra computadora como un conjunto de símbolos traducidos en lógica binaria, “para cada número computable debe haber el número de una máquina que le corresponda” y propuso:

“[…] (en su imaginación todavía) una versión de la máquina que fuera capaz de simular todas las otras máquinas posibles —cada computadora digital―. Él la llamó ‘máquina de U’, significando ‘universal’, y, hasta el día de hoy, los matemáticos siguen usando con cariño el nombre ‘U’. Ésta recibe como entrada los números de máquinas. O sea, lee la descripción de otras máquinas desde su cinta —sus algoritmos y su propia entrada―. Por más que una computadora digital pudiera tornarse compleja, su descripción podría ser codificada en una cinta que todavía sería leída por U. Si un problema puede solucionarse por cualquier computadora digital —codificado en símbolos y solucionado aritméticamente—, entonces, la máquina universal también podrá resolverlo”.[5]

Lo que Turing estaba proponiendo, teóricamente, es que todo tipo de operaciones que pudiera ser codificado en número binarios, podrían ser computadas por una máquina adecuadamente programada. Para que la máquina de Turing pudiera realizarse como una máquina de información o una computadora digital, hacía falta, por un lado, la Teoría Matemática de la Información de Claude Shannon y Warren Weaver, con su capacidad de traducir no solo símbolos, sino —como veremos adelante— todo tipo de información en un “lenguaje universal”: el de los bits. Por otro lado, faltaba que la máquina U no solo lograse leer cualquier codificación de una máquina digital, sino también que ella tuviera almacenada en su propio programa todas esas codificaciones. Eso fue lo que propuso John Von Neumann, otro de los padres de la computación.

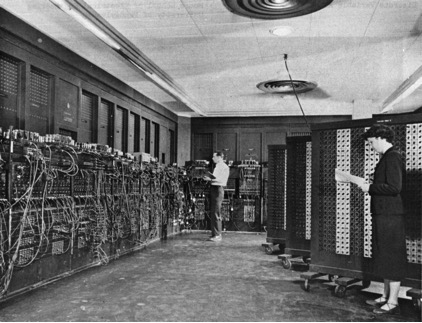

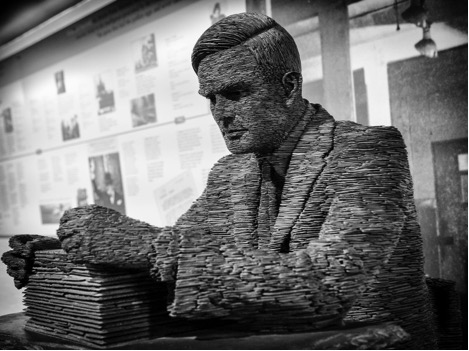

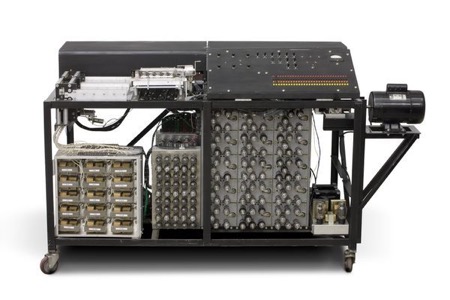

Dos de las primeras computadoras —que en realidad eran inmensas máquinas de calcular— la ABC (Atanasoff Berry Computer) y la ENIAC (Eletronic Numerical Integrator and Computer) llevaban una significativa dificultad en su funcionamiento todavía, pues siempre que terminaban una operación de cálculo, los operadores tenían que cambiar manualmente los cables de la máquina y reprogramar sus operaciones.

“Von Neumann pensó entonces que se podía generar un conjunto de instrucciones (los algoritmos de la máquina de Turing) que estuvieran almacenados en la máquina y que ésta activara lo que necesitara, con una orden dada desde afuera, sin necesidad de “tocarla” físicamente. A la vez, también los datos y los resultados de esos datos combinados en cálculos podían ser almacenados en el mismo lugar, a la que llamó una unidad de memoria”.[6]

ATANASOFF BERRY COMPUTER

Lo que estaba proponiendo Von Neumann era una especialización de la máquina en sus partes (en el caso recién mencionado respectivamente: microprocesadores y disco rígido) que operarían programas distintos, pero que podrían comunicarse perfectamente en el lenguaje digital. Conociendo los estudios de las redes de neuronas de McCulloch y Pitts, que proponían que las sinapsis funcionaban de modo binario, Von Neumann propuso una máquina que pudiera operarse a sí misma comparándola con un cerebro humano. Como dijimos, hay un curioso camino que va de la abstracción de las computadoras humanas a las computadoras digitales para potencializar su capacidad de cálculo y operación, para, de este modo, poder llegar finalmente a pensar como un cerebro humano. Es precisamente ello lo que ha creado el famoso debate de la Inteligencia Artificial y de la Filosofía que consiste en la pregunta ¿puede una computadora pensar? Ahora bien, lo que se buscaba era potencializar el pensamiento en el proceso de búsqueda de una máquina, para lograr la capacidad de pensamiento del cerebro, pendiéndose así los distintos modos del pensamiento que el cerebro tiene, como se verá más adelante.

Más allá de las invenciones que Turing, Von Neumann y muchos otros[7] posibilitaron, una asombrosa creación fue la de una máquina capaz de codificar y decodificar desde su programación un “lenguaje universal” que procesaba una cantidad cada vez más amplia de datos y procesos. Hablando en el lenguaje del sentido común, podemos decir que presentamos brevemente cómo se construyó el hardware de las computadoras digitales. Ahora precisamos presentar, por así decir, el software que puso esa máquina en funcionamiento: el “lenguaje universal” de los bits que propuso Shannon y Weaver con su Teoría Matemática de la Información (TMI).

Lo que las computadoras de Turing y Von Neumann habían logrado en aquel momento era, por decirlo analógicamente, crear una imagen de máquina universal para efectuar operaciones, proponiendo que, si el telar de Jacquard fuera también codificado en el lenguaje de los cartones perforados, la operación del telar podría ser reproducida en cualquier máquina —un poco como proponía ya Lovelace para la Máquina Analítica—. El punto clave de ese cambio de enfoque estuvo en el descubrimiento de una noción que permitiera la comunicación general de todas las máquinas, una equivalencia entre todo tipo de operaciones. Ese proceso empieza cuando el enfoque científico gradualmente se disloca de la materia a la energía. La noción demasiado concreta de materia exigía una conversión analógica entre materiales adaptados a las operaciones de las distintas máquinas.

ADA LOVELACE

Así, con los avances de las tecnologías del transporte y energéticas, ya en el siglo XIX la cuestión de la transmisión de signos y señales (eléctricas y electromagnéticas) se puso en el centro de las preocupaciones de los científicos que trabajaban con las tecnologías de transmisión (telégrafo, teléfono, radio, y, después, también cine y televisión). “De hecho, las ‘utopías del vínculo universal’, que avizoraban un mundo feliz por obra y gracia de las transformaciones de los transportes y de las transmisiones, pertenecen al siglo XIX”.[8] Esas “utopías del vínculo universal” van a alcanzar su versión más terminada —y casi podríamos decir definitiva— en el siglo XX con la propuesta cibernética de equivalencia entre todos los seres y procesos por medio de la información. “La cibernética instaura como punto de partida la identidad entre la vida, el pensamiento y el lenguaje. Este monismo radical se funda en una analogía entre las nociones de información y de energía”.[9]

Esa relación entre información y energía empieza a ser fuertemente desarrollada en un contexto histórico-económico muy específico. En la primera mitad del siglo XX, se consolidó la centralidad de las empresas de telecomunicaciones y de las fuerzas armadas en el contexto geopolítico y económico de las dos guerras mundiales. No por casualidad los científicos que desarrollaron las bases de las tecnologías de la información y de la computación se concentraban en los Laboratorios Bell, en la empresa de telefonía AT&T (American Telephone and Telegraph) o en las fuerzas armadas. Los problemas fundamentales que desafiaban esos científicos era el perfeccionamiento de las transmisiones de mensajes al tiempo que intentaban reducir los ruidos procedentes de la corriente eléctrica y el desarrollo de técnicas de criptografía para cifrar o descifrar mensajes. Por ejemplo, Shannon luego de graduarse en MIT, donde fue alumno de Norbert Wierner, desarrolló una máquina automática de control de disparo de las baterías antiaéreas y también buscó demostrar que el Sistema X de criptografía o “la línea telefónica directa entre Winston Churchill y el presidente Roosevelt”[10] era segura; además, trabajaba también para los Laboratorios Bell. Por otro lado, Turing trabajó para el ejército británico en la construcción de una máquina que logró descifrar el Enigma —el sistema criptográfico nazi utilizado en las comunicaciones más importantes de guerra, como aquellas enviadas a los submarinos— rescatando y poniendo en operación las experiencias mentales propuestas en su ensayo de 1936 sobre números computables.

Pero, justamente en medio de ese contexto algo cambió, pues, si en el caso de la criptografía los problemas de transmisión e interceptación de mensajes como maneras de controlar la comunicación y la información estaban claramente puestos en la centralidad de la noción de código, en el caso de las tecnologías de telecomunicación que estaban en desarrollo la centralidad del código fue un verdadero descubrimiento. El código fue un método para programar los sistemas de comunicación y las máquinas de información, organizando y tornando posible el vínculo universal sobre las conversaciones que se mantenían en la superficie.

El siglo XIX nos legó el problema de la transmisión de las señales en los canales de comunicación y estuvo en el centro de las preocupaciones de los ingenieros y científicos de las telecomunicaciones en la primera mitad del siglo XX, la búsqueda de perfeccionamiento de esas transmisiones por medio de la medición de las deformaciones (ruidos) que podrían ocurrir en los distintos tipos de canales, por ejemplo, la corriente eléctrica. Lo que empezó a ocurrir, entonces, fue el desplazamiento del interés central por el perfeccionamiento de los canales y de las señales de la comunicación para la generación de un código que asegurase la identidad de la información en los tres momentos del proceso: emisor-mensaje-receptor. En eso se enfocaron científicos como Harry Nyquist y Ralph Hartley ―este último, fue uno de los primeros en proponer que se midiera la información con el modelo funcional que hizo que hasta los años cincuenta la información fuera medida en hartleys―. En dicho momento clave de búsqueda de un código que permitiera la medida y control de la información es que aparece la Teoría Matemática de la Información (TMI).

“Con el cálculo estadístico, la TMI reformuló aquello que buscaba Nyquist: la codificación de las señales. Ya no se trataba sólo de derivar el código de las propiedades de la corriente eléctrica (de donde proviene el sistema digital como opuesto al analógico), sino de generar un código, o llegar a conocer un código ya existente, de manera tal que se pudieran evitar las interrupciones del mensaje transmitido debido a problemas físicos o de otro tipo”.[11]

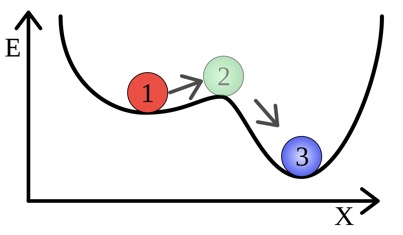

Diciéndolo de manera muy resumida, la preocupación se desplazó del intento de disminuir el ruido en la emisión y recepción de las señales a la capacidad de medir la redundancia en la transmisión de información. Hubo un cambio radical de enfoque en ese desplazamiento: era imposible prever y descifrar el comportamiento de cada una de las moléculas o partículas en la transmisión ―así como vaticinaba el principio de la incertidumbre de Heisenberg para los problemas físicos―, pero se podría determinar un patrón de medida de información que garantizase la identidad por medio de código en la entrada y en la salida de una transmisión. El mensaje entra en el sistema de comunicación codificado (emisor) pasa por el canal (medio de transmisión) en el que sufre alteraciones que introducen ruido en el mensaje y llega al punto de salida (receptor), que interpreta por medio del código, diferenciando mensaje y ruido. Así pues, lo fundamental fue crear un patrón de medida para la información que pudiera establecer el código al ser utilizado y programado en los sistemas de comunicación. Eso fue lo que hizo Shannon al proponer el bit (binary digit) como unidad mínima de medida de la información en el artículo que la Scientific American denominó como la “Constitución de la Era de la Información”.[12]

Finalmente, los dos ejes que produjo la constitución de la máquina digital son:

- La capacidad de cuantificar todo tipo de información por medio de un “lenguaje universal”: el lenguaje binario codificado de los bits.

- La creación de una máquina capaz de codificar y decodificar ese lenguaje desde su programación, procesando una cantidad cada vez más amplia de datos y procesos.

Pero, esos dos ejes solos no explican cómo se configuró el vínculo universal que permitió, por un lado, la postulación de la comunicación general de todos los seres por medio de los intercambios de información y, por otro, la semejanza entre cerebro y máquina como una equivalencia entre pensamiento y programa de información. Si se tratara solo de estos ejes fundamentales para la constitución de la computadora digital, esas creaciones habrían quedado restringidas al campo de las telecomunicaciones y de la computación matemática. Sin embargo, algunas ciencias abrazaron una reactualización de la búsqueda del vínculo universal que propuso la cibernética, no solo como una analogía entre energía e información, sino como un sistema universal de comunicación y control, tornado posible por la codificación digital de la información.

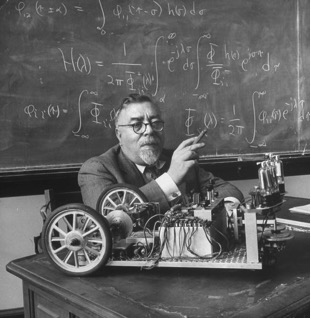

Cibernética, biología molecular, lingüística, neurociencias y las más distintas teorías de los sistemas de información y comunicación (como, por ejemplo, la Teoría General de los Sistemas de Bertalanffy) participaron en la construcción común de la idea de que, del código genético al funcionamiento del cerebro; de los seres físicos y organismos vivientes a las máquinas y del átomo o de las partículas más elementares a los planetas y satélites, todos los seres y fenómenos emiten, reciben, almacenan y tratan informaciones. Ese sistema de comunicación general en que todos los seres transmiten e intercambian informaciones fue lo que, de modo general, la cibernética de Norbert Wierner propuso como proyecto de unificación de las ciencias, técnicas y discursos.

NORBERT WIENER

La cibernética, según la definición de Wierner, su fundador, es la ciencia que estudia el control y la comunicación en los animales, hombres y máquinas. Esta se consolidó en el mismo contexto histórico, económico y geopolítico que describimos anteriormente en el advenimiento de las computadoras digitales. La palabra “cibernética” deriva de la palabra griega kybernetes que puede ser traducida tanto como “piloto” o como “gobierno”;[13] también puede tener origen en kybernesis que significa “acción de pilotar una nave” o, de modo figurativo, podía ser utilizada con el sentido de “acción de dirigir o gobernar”.[14] Entonces, el propósito de la cibernética fue caracterizado por Wierner como el de “[d]esarrollar un lenguaje y técnicas que nos permitan, de hecho, enfrentarnos con el problema del control y de la comunicación en general, y descubrir el repertorio de técnicas e ideas para clasificarles las manifestaciones específicas de acuerdo con ciertos conceptos”.[15]

Con la codificación digital de la información, la cibernética —y casi todos los otros campos del conocimiento— pasó a comprender todos los tipos de seres (físicos, vivientes, psicosociales y técnicos) como partes de un mismo sistema universal de comunicación, pues “[…] los seres humanos no somos los únicos que leemos, escribimos y interpretamos en este mundo”.[16] No existiría más la separación entre naturaleza y cultura, entre las palabras y las cosas, pues ambas harían parte, entonces, de un mismo sistema de comunicación general basado en la noción de información. La radicalidad y amplitud de esa comprensión nos llevaría a creer que:

“Ahora podemos ver que la información es aquello que nutre el funcionamiento de nuestro mundo: la sangre y el combustible, el principio vital. Ella permea la ciencia de arriba a abajo, transformando todas las ramas del conocimiento. La teoría de la información empezó como un puente de la matemática a la ingeniería eléctrica y, entonces, la computación. No por casualidad, la ciencia de la computación también es conocida como informática. Hoy, incluso la biología se convirtió en una ciencia de la información, sujeta a los mensajes, instrucciones y códigos. Los genes encapsulan informaciones y permiten procedimientos para que estas sean leídas desde ellos e inscriptas en ellos. La vida se expande por medio del establecimiento de redes. Hasta el cuerpo es un procesador de informaciones. La memoria reside no sólo en el cerebro, pero en cada célula. No sorprende, así, que la genética tenga aflorado juntamente con la teoría de la información. El ADN es la molécula de información por excelencia, el más avanzado procesador de mensajes en nivel celular — un alfabeto y un código, billones de bits para formarse un humano”.[17]

Ahora, en el momento mismo en que la codificación digital de la información empezaba a ganar toda su fuerza, algunos científicos y filósofos le opusieron la posibilidad de una comprensión alternativa, uno de ellos fue Gilbert Simondon.

La procesualidad metaestable de la información y las máquinas abiertas

La filosofía de Simondon es una de las más fecundas para que pensemos caminos alternativos a las máquinas cibernéticas y la información digital que tienen hegemonizadas y controladas las posibilidades técnicas y vitales de los modos de vida contemporáneos. En un trabajo anterior, presentamos cómo la noción de información fue enfrentada por Simondon como “objeto de su mayor desafío teórico”[18] en la construcción de una noción alternativa de información como procesualidad ontogenética. Eso le permitió “instaurar una nueva metafísica ―de religación del ser y del devenir como condición de la ontogénesis― que solo caracteriza los procesos como una degradación de una fuente inteligible”[19] —como lo hicieron las más distintas tradiciones del platonismo y del hilemorfismo— ni como elemento que permite la absoluta identidad y control de los procesos por medio de la codificación homogeneizante del receptor, del emisor y del mensaje —como lo construyeron los dispositivos cibernéticos—. “Resumidamente, lo que propone Simondon es que la propia identidad del código y de su operatividad son ellos también procesuales y, así, se transforman según los procesos de transformación o individuación de los individuos (físicos, vivientes, psicosociales y técnicos) detentores de ese código”.[20]

Mientras las computadoras eran perfeccionadas y los cibernéticos construían sus teorías de estructuración y control de los modos en que los seres pueden operar y se comunican por medio de los dispositivos de codificación de la información —para garantizar la identidad y unidad del emisor al receptor—, Simondon proponía que la información es el nombre de un proceso de transformación. “Ser o no ser información no depende solamente de los caracteres internos de una estructura; la información no es una cosa, sino la operación de una cosa que llega a un sistema y que produce allí una transformación. La información no puede definirse más allá de este acto de incidencia transformadora y de la operación de recepción”.[21] El centro de esa concepción de información está en un pensamiento ontogenético que postula la metaestabilidad de la información,[22] y lo hace rechazando la confusión de la información con el código y con la señal.[23] Mientras los ingenieros de las telecomunicaciones y los inventores de las primeras computadoras digitales trabajaban en el perfeccionamiento de la transmisión de las señales y los cuantificadores de la información y los cibernéticos se ocupaban en producir la identidad y unidad entre código, señal e información, Simondon alertaba los riesgos que tal uniformización produciría en la captación de los procesos informacionales. Veamos brevemente qué teoría alternativa de la información nos regala Simondon y cómo esta puede señalar otra comprensión técnica de la máquina.

La teoría simondoniana de la información fue construida, en primer lugar, desde la crítica de la tradición platónica de la separación entre forma activa y materia pasiva; y, también, desde la tradición del hilemorfismo aristotélico y de la tradición substancialista que no lograba conocer el proceso de individuación propiamente, sino solo de los individuos ya constituidos o sobre un principio abstracto de individuación. El aspecto central de la crítica simondoniana de todas esas tradiciones es la constatación de que ellas operan separando forma y materia en un primer momento, para, después, reunirlas identificadas con una estructura cuyo nombre es individual.[24]

El individuo fue para la tradición occidental de pensamiento la estructura fundamental para el conocimiento de las relaciones entre ser y devenir, y, justamente, por identificar el devenir como epifenómeno de las realidades individuales, es que esa tradición no pudo pensar, según Simondon, adecuadamente las transformaciones o el devenir del ser. El individuo fue la ficción del pensamiento creada como símbolo supremo de la irremediable separación entre ser y devenir ―lo que según Simondon impidió un verdadero conocimiento de las procesualidades de los seres, de sus procesos de individuación y su ontogénesis―. En ese sentido, la cibernética al comienzo surgió como una búsqueda de enorme importancia para Simondon, dado que ella proponía pensar la información como “operación” y “relación diferencial”, pero “la cibernética descubrió a cuestión de las operaciones, en lugar de las estructuras, para luego recostarse sobre éstas últimas, malogrando la posibilidad preciosa para vincular la información con el devenir”.[25]

Para Simondon, ese enfoque de la cibernética en la estructuración o codificación que la información puede producir deriva de su interés en el aspecto cuantitativo de la información. Según el filósofo, las definiciones y usos de la cibernética y de la teoría de la información “[…] se reparten en dos grandes corrientes: una que aborda la información por su aspecto cuantitativo y controlable, y otra, por su aspecto cualitativo y contingente”.[26] Esa división ocurre como consecuencia del enfoque que la cibernética y la Teoría Matemática de la Información (TMI) pusieron en las operaciones de transmisión y codificación de la información. En estas operaciones, lo importante sería establecer la diferencia entre ruido y mensaje significativo; o sea, el propio trabajo para captar y transmitir informaciones significativas obliga a que estas no sean totalmente contingentes, pues de otro modo no se diferenciarían del ruido, así como también obligan a que no sean totalmente previsibles, pues así no se diferenciarían del código. En ese camino de captación de cómo las operaciones transforman las estructuras y de cómo implican las operaciones en los procesos de individuación, la cibernética y la TMI habrían individualizado nuevamente las operaciones del ser —es decir, las operaciones de información— por medio de la uniformización de los procesos en la lógica binaria de lo digital. Una vez más, se fundó un principio de inteligibilidad y de control para las individuaciones al estabilizar la tensión metaestable de la información, simultáneamente contingente y previsible, cuantitativa y cualitativa. Lo que hace Simondon, entonces, es recuperar esa dimensión metaestable de las operaciones de información.

En resumen, lo que propone Simondon es una teoría de la información que converge esos dos sentidos complementarios (cualitativo y cuantitativo), pero con un enfoque en la diferencia cualitativa que la información produce en un proceso, en la transformación que produce en el receptor.[27] Es en ese sentido que “[…] la información es, a la vez, una operación que produce una transformación en un sistema o en un receptor, y ese propio proceso de transformación cuyo nombre es ontogénesis”.[28] Lo que Simondon reprobaba a la cibernética —y que las tecnologías de digitalización del mundo tienen radicalizado— es haber olvidado o borrado la dimensión cualitativa de la información, el sentido de procesualidad y devenir en lo que las operaciones de información poseen. Así, lo que habría que reprobar a las máquinas digitales no sería la estructuración del mundo como un sistema de comunicación digital entre máquinas informacionales —acordándose de que todos los seres (físicos, vivientes, psicosociales y técnicos) han sido reducidos a interfaces de información digital—, sino la eliminación de los sentidos complementarios a la digital. Como veremos con Ronald Cicurel y Miguel Nicolelis, no se trata de decir que una parte del funcionamiento del cerebro no pueda ser digitalizada ―informada en lenguaje de ceros y unos, de activación o no-activación de las redes sinápticas―, pues si así fuera no habría posibilidad de reproducir los procesos sintácticos del cerebro en una máquina ―como fue realizado por el propio Nicolelis y un equipo inmenso de investigación en el desarrollo del exoesqueleto de la Copa del Mundo del 2014―, sino de no borrar la dimensión analógica o semántica de las máquinas digitales. Como veremos adelante, tal tipo de complementariedad es lo que ellos proponen el su “Teoría del Cerebro Relativístico”, comprendiendo el cerebro como un “sistema hibrido analógico y digital” que procesa dos tipos de informaciones que ellos denominan información de Shannon-Turing e información Gödeliana.[29]

Finalmente, es interesante mencionar brevemente otro aporte que Simondon nos ofrece para pensar la ampliación del sentido de la máquina digital. En el texto La mentalidad técnica, Simondon propone un análisis de dos tipos de esquemas cognitivos-maquínicos en el que ocurre la analogía entre un modo de funcionamiento del pensamiento y un modo de comprensión del funcionamiento de las máquinas: el mecanicismo cartesiano y la teoría cibernética. No podemos detenernos acá en la presentación pormenorizada del análisis simondoniano de esos dos esquemas cognitivos, pero en líneas generales, podemos señalar que hay un encuentro de ambos en la máquina digital. Por un lado, la máquina digital hereda del mecanicismo cartesiano su hardware transferencial; en cierto sentido, aunque la computadora digital haya evolucionado sus partes, su funcionamiento sigue siendo el de la máquina simple. “Una máquina simple es un sistema de transferencia que establece la identidad entre un trabajo motor y un trabajo resistente, en el caso particular en el cual el desplazamiento se supone reversible, en el estado de equilibrio”.[30] Por más que en la máquina digital ocurra un cambio y la transferencia establezca la identidad entre un trabajo eléctrico o electromagnético y un trabajo informacional o digital, el principio de la transferencia y uniformización de las partes técnicas sigue ahí funcionando. “Si cada pieza de la máquina opera rigurosamente esta transferencia, el número de piezas puede ser cualquiera; solo se ejecutan cambios de dirección de las fuerzas —como con la polea— o cambios de factores (fuerza y desplazamiento) de un producto que se mantiene constante, en el caso del aparejo”.[31] Es ese principio lógico de transferencia entre partes que forman un organismo como sistema cerrado es lo que está en la base de los procesamientos de la Máquina U de Turing y en las reprogramaciones de la computadora de Von Neumann, como vimos anteriormente.

Por otro lado, la teoría cibernética instala la posibilidad de un dispositivo de relevos o dispositivo de modulación “[…] como esquema de base, que permite una adaptación activa a un fin dotado de espontaneidad. Esta realización técnica de una conducción finalizada sirvió de modelo de inteligibilidad para un gran número de regulaciones ―o de fracasos de regulaciones― en lo viviente, humano o no humano, y de fenómenos sometidos al devenir”.[32] Es el principio mismo de la regulación de las relaciones entre seres como cuantificación de la información en la entrada y salida de un sistema de información que está describiendo Simondon. Es la medida probabilística del grado de incertidumbre en un sistema y el control estadístico de la circulación de las señales, por medio del código que buscó Shannon con la TMI, lo que Simondon describe como dispositivo de relevos o de modulación. Ahora, menos importante que identificar estos dos esquemas en la base de la máquina digital, es escuchar lo que Simondon señala como resultado del empleo de eso esquemas:

“Ninguno de los esquemas agota un dominio, pero cada uno de ellos da cuenta de un cierto número de efectos en cada dominio y permite pasar de un dominio a otro. Este conocimiento transcategorial, suponiendo una teoría del conocimiento que sea pariente cercano de un verdadero idealismo realista, es apto para aprehender la universalidad de un modo de actividad, de un régimen operatorio; deja de lado el problema de la naturaleza intemporal de los seres y de los modos de lo real; se aplica a sus funcionamientos, tendiendo hacia una fenomenología de los regímenes de actividad, sin presuposición ontológica relativa a la naturaleza de lo que entra en actividad. Cada uno de los esquemas se aplica solamente a ciertos regímenes de cada región, pero puede de derecho aplicarse a algún régimen de cualquier región”.[33]

Lo que Simondon anticipa en su análisis de la mentalidad técnica es un modo de operación de la codificación digital que se va a generalizar con cada vez más contundencia, esto es, un dispositivo de uniformización que ignora los sistemas de organizaciones singulares de los seres y las diferencias de naturaleza de los tipos de individuación. El problema, finalmente, no es que se encuentren en el cerebro ciertas semejanzas operatorias con la máquina, sino que la máquina no establezca ninguna relación de analogía con los modos de individuación del cerebro, que no se reducen al funcionamiento binario de lo digital; que la máquina no esté abierta a la dimensión afectiva, axiológica y no-binaria del cerebro.

Tres figuras de la máquina digital y sus límites

Este ensayo se instala en medio de una discusión contemporánea que está movilizando, además de la neurociencia y la inteligencia artificial, importantes campos de las ciencias. El eje del debate que aquí se presenta nace de la oposición de dos científicos en relación con la posibilidad de la digitalización total del cerebro. Representando dos corrientes opuestas, están, de un lado, Ray Kurzweil —director de ingeniería de Google y un importante inventor de tecnologías, como el sintetizador y dispositivos de reconocimiento de voz— que cree y difunde vehementemente la idea de que el cerebro es una máquina digital, y, del otro lado, Miguel Nicolelis, un importante neurocientífico que tiene revolucionado los dispositivos de interacción y sus posibilidades entre cerebros y máquinas, pero que defiende radicalmente que “[…] cualquier tentativa de simular correctamente la complejidad intrínseca de un cerebro animal en un computador digital o en cualquier otra máquina de Turing, está destinada al fracaso”.[34]

Lo que presentaremos ahora, articulando el debate entre Kurzweil y Nicolelis, son tres figuras de las promesas de la máquina digital y cómo esas conllevan, en su propio modo de operación, algunos límites que parecen epistemológica y ontológicamente insuperables. Esa articulación es un modo de hacer resonar lo que presentamos anteriormente sobre el pensamiento de Simondon en los debates contemporáneos.

Los límites de la computabilidad: de la Máquina de Turing a la Máquina del Oráculo

Lo que presentamos en el comienzo sobre la Máquina U de Alan Turing, como una máquina universal que podría computar o procesar todo tipo de operaciones, es una idea exitosa en muchos campos del conocimiento, pero principalmente en las neurociencias y en la inteligencia artificial. Más importante que las búsquedas, invenciones, cuestiones y debates que produjo la pregunta fundamental del llamado “Test de Turing” sobre la posibilidad de una máquina de pensar, fue el ejercicio mental que hizo Turing de sí, al menos teóricamente, acerca de si habría la posibilidad de que una computadora pudiera “[…] ejecutar cualquier algoritmo que podamos definir, por causa de su universalidad inapta (sujeta solo a su capacidad)”.[35] Lo que la universalidad de la máquina de Turing colocaba como posibilidad y que el lenguaje binario de los bits parecía tornar posible, es que todo tipo de operaciones fuera ejecutado por una computadora desde que se encuentra uniformizado por un mismo programa.

“Es verdad que una computadora y un procesador de texto existen en niveles conceptuales distintos, pero una computadora puede tornarse un procesador de texto si hay un programa de procesamiento de texto en ejecución en ella, y no al revés. Así también, una computadora puede tornarse un cerebro si hay un software cerebral siendo ejecutado. Es eso que investigadores, incluso yo, estamos intentando hacer”.[36]

Lo que había empezado como una posibilidad restringida a los fenómenos tecnológicos fue ampliado para todo el espectro de los individuos (físicos, vivientes y psicosociales) gracias a la fuerza de las ideas de la cibernética. Lo que presentamos al comienzo y, más específicamente, lo que la Máquina de Turing simboliza, es la posibilidad de que todos los procesos que existen puedan ser procesados por una máquina universal que tenga el software correcto, los algoritmos correspondientes o que hagan dicha correspondencia. Para sus defensores, esa idea fue coronada con lo que se quedó conocida como la tesis de Church-Turing: “Interpretaciones ‘fuertes’ de la tesis Church-Turing proponen una equivalencia esencial entre lo que un humano puede pensar o saber, y lo que es computable por una máquina”. Esa tesis nunca fue comprobada por un humano o una máquina, pero su idea básica tiene movilizado al campo conocido como hipercomputación. “La idea básica es que el cerebro humano está también sujeto a la ley natural y, de este modo, su capacidad de procesamiento de informaciones no puede exceder la de una máquina (y, así, la de una máquina de Turing)”.[37] Pero, curiosamente, no fueron ni Turing ni Shannon los que propusieron los caminos para esa tesis, sino von Neumann.

“El insight fundamental de von Neumann fue el de que había una equivalencia esencial entre una computadora y el cerebro. Perciba que la inteligencia emocional de un ser humano biológico es parte de su inteligencia. Caso sea correcto el insight de von Neumann, y se aceptan mi declaración de fe de que una entidad no biológica, que vuelve a crear de modo convincente la inteligencia (emocional y otras) de un humano biológico, tiene consciencia, entonces tendremos que concluir que existe una equivalencia esencial entre una computadora —con el software correcto— y una mente (consciente)”.[38]

JOHN VON NEUMANN

La tesis central de Kurzweil, apoyada en la semejanza que propuso von Neumann, depende de una premisa fundamental sobre la computabilidad: que todos los procesos tanto de la máquina como del cerebro son digitalizables; las operaciones de los seres no digitales pueden ser procesadas por una Máquina de Turing en la medida en que se pueda convertir la información analógica ―pegada a la materialidad de los seres― en información digital (“inmaterial”), que pueda ser ejecutada en cualquier computadora. “La mayoría de las computadoras son hoy enteramente digitales, mientras el cerebro humano combina métodos digitales y analógicos. Pero, los métodos analógicos son sencilla y rutineramente recreados por los digitales, con cualquier nivel deseado de precisión”.[39]

Esa premisa de Kurzweil contiene algunos problemas que fueron apuntados en la época ya por el propio Shannon y por Turing. Primeramente, con la generalización de que la concepción digital de la información comenzaba a utilizarse en los campos más diversos de la psicología, antropología, lingüística, biología y economía. Por ello, Shannon en 1956 alertaba sobre un elemento peligroso en esa uniformización:

“Él recordó a todos que, en su núcleo duro, la teoría de la información era una rama de la matemática. Personalmente él acreditaba que sus conceptos se mostrarían útiles en otros campos, pero no en toda parte y tampoco que serían sencillo adaptarlos: ‘La definición de tales aplicaciones no es una cuestión trivial de traducción de palabras en un nuevo dominio, y sí el lento y tedioso proceso de establecimiento de hipótesis y su verificación experimental’. Además de eso, Shannon pensaba que el trabajo duro mal había empezado en ‘nuestra propia casa’. Él insistía en más investigación y menos exposición”.[40]

La alerta de Shannon era justamente que una noción matemática, basada en la lógica binaria, estaba siendo adaptada para otros campos de conocimiento, con objetos de estudio (seres) distintos, sin la debida investigación científica y experimental que podría ofrecer consistencia, parámetros y límites para las adaptaciones y conversiones. Eso es lo que Nicolelis y Cicurel advierten en la noción de información digital como una noción sintáctica que no alcanza la complejidad de la dimensión semántica de los procesos informacionales de los seres.[41] Eso fue también lo que algunos cibernéticos y el propio Simondon advirtieron como una traspolación. “En cierto estricto, este concepto de información implica una traspolación de los esquemas tecnológicos tomados de la informática y la ingeniería en telecomunicaciones a realidades no directamente tecnológicas, como los fenómenos vivientes y sociales, algo que será fustigado por el propio Simondon”.[42] Ese era y es fundamentalmente el riesgo de uniformizar todos los seres en un esquema cognitivo que transformaba todos los fenómenos y seres en máquinas digitales.

Ahora, volviendo a la apuesta de Kurzweil de que las computadoras imitarán los cerebros en un futuro próximo, la pregunta sería ¿qué tipo de informaciones cerebrales pueden ser convertidas en lenguaje digital? Según Nicolelis, la actividad eléctrica cerebral que es análoga ―y, por tanto, necesita de las debidas adecuaciones entre operaciones― y la actividad eléctrica de las redes tecnológicas. La parte de información digital del cerebro puede ser abstraída por complejos procedimientos en lenguaje digital, es decir, el de los bits. Pero, “[…] en un cerebro, la información obtenida exteriormente (digital y formal) jamás será capaz de describir por completo la visión de realidad descripta por la información del interior del cerebro (analógica e integrada)”.[43]

Lo que hace falta es que el tipo de simbolización y de construcción de sentido, hecho por la individuación del cerebro pudiera ser codificado en lenguaje binario, lo que haría factible la propuesta de Kurzweil. El propio Alan Turing ya había separado ese límite de la computabilidad: una dimensión exterior o un ser analógico tendría que donar los sentidos y símbolos complementares a la actividad de procesamiento de las máquinas de Turing.

“Estando consciente de las limitaciones de su máquina de Turing, ya en su tesis doctoral, publicada en 1939, Alan Turing intentó superar esas limitaciones al concebir un nuevo concepto que él denominó de máquina del Oráculo. El objetivo central de esa máquina del Oráculo fue la introducción de una herramienta del mundo real para reaccionar a todo aquello que ‘no podría ser realizado mecánicamente’ por la máquina de Turing. Así, la máquina del Oráculo fornecía un ‘consejo externo’ que podría ser consultado y activado en algunos pasos del cálculo que no podrían ser solucionados algorítmicamente por la máquina de Turing. Una vez que el Oráculo ofertase a su respuesta, la computación mecánica podría ser reiniciada. En otras palabras, el Oráculo sería siempre convocado para resolver un paso no-computable”.[44]

Ese límite epistemológico y tecnológico de la computabilidad, tenía en su base un límite ontológico —o para decir en lenguaje simondoniano, ontogenético— que venía entramado en el tejido digital desde el telar de Jacquard o antes.

Los límites del binarismo: de la Máquina de Jacquard al Cerebro Relativístico

Lo que vamos a presentar brevísimamente ahora es una idea ―o un idealismo― que tiene larga trayectoria en la historia del pensamiento; se trata del eje central, con sus gamas de variaciones históricas de la ontología de la información digital. Ya vimos anteriormente que, a esa ontología meramente cuantitativa y algorítmica, Simondon le oponía una ontogénesis de la información simultáneamente cuantitativa y cualitativa. En una palabra, la información para Simondon no podría ser reducida a una imagen o a un número, pues eso sería estructurarla en una codificación fija, perdiéndole su devenir o su potencia de transformación.

Como vimos antes, el telar de Jacquard —y también de la Máquina Analítica de Babbage y Lovelace— pueden ser comprendidas como el prototipo de la máquina digital. Eso porque realizaba de manera sumamente contundente una idea que la matemática, principalmente, había perseguido durante mucho tiempo (aunque también de muchas otras ciencias): la posibilidad de representar la esencia compleja de cualquier ser, por medio de símbolos sencillos. La máquina de Jacquard parecía comprobar la posibilidad de reproducir cualquier imagen o design de imagen por más compleja que fuera, por medio de simples agujeros en cartones perforados. Que fuesen necesarios miles de cartones y después millones o billones de bits para representar la más sencilla de las imágenes no era un problema, pues incluso confluía con la invención de las computadoras digitales para la construcción ideológica de que el cerebro habría que ser suplantado por un dispositivo con capacidad de cálculo superior a las limitaciones de su procesamiento. El telar de Jacquard hacía que los nudos de distintas tradiciones idealistas se encontrasen para entramar el tejido de la más potente ficción contemporánea: toda la complejidad del ser y de sus transformaciones puede ser codificada y reproducida en un lenguaje universal de ceros y unos, de sí y no, de presencia y ausencia en lógica binaria.

Ahora, esa ficción ontológica históricamente construida, tiene una premisa fundamental de base: la información diferente de la materia y de la energía, sería una realidad inmaterial. La pretendida virtualidad o inmaterialidad de la información, como lo analizó Rodríguez, respondía a las preocupaciones de las esencias platónicas, de la conciencia desencarnada de Descartes, de las relaciones entre las formas y los esquemas como preparación para lo sensible de la estética kantiana o de espíritu objetivo que buscaba Hegel.[45]

La inmaterialidad de la información resolvía el impase filosófico y científico de la oposición entre materia y espíritu, cuerpo y alma, naturaleza y cultura. En ese sentido, la información abría una gran posibilidad, pues ella “[…] representa algo del orden de lo espiritual encarnado en la materia, que ahora tiene capacidad de pensamiento, de acción, hasta sentimiento”.[46] Solo que, para las finalidades de la máquina digital, la información habría que ser desencarnada nuevamente, abstraída de la individuación en que se plegó y se repliega, para comportarse como software puro apartado del hardware material. Y en el propio desarrollo técnico de las computadoras, era comprensible que esa separación regresase dado que una nueva oposición allí nacía: la del ordenamiento material (hardware) y el ordenamiento lógico (software).

“La investigación sobre la información siempre operó con entidades materiales, desde los cables de telecomunicaciones del siglo XIX hasta el tubo de ensayo de una computadora cuántica, pasando por el ADN y los transistores. Es cierto que la distinción entre el ordenamiento material y el lógico de la computadora, en la formulación de Von Neumann, parece contradecir el materialismo de la información, y lo hace en un terreno sensible porque de allí salió la computadora, máquina de información por excelencia, y de allí emergió también la diferencia entre software y hardware”.[47]

Así, podemos decir que la información digital reconfiguró los pares oposicionales de la tradición moderna de pensamiento, pero lo hizo instalando un nuevo par binario, el del software inmaterial y del hardware material. Hoy lo que está en disputa en varios campos de la ciencia, como la genética y las neurociencias, es que avanzamos con la información hasta “un nuevo punto de vista sobre la materialidad”[48] que podríamos llamar de pluralidad ontogenética y de la que consideramos el monismo ontológico de la información inmaterial como base de aprehensión y representación del ser. Si no hay pluralidad ontogenética, sería una cuestión solo de tiempo para que, afirmaciones como esta, sean cada vez más reales:

“Tengo acuerdo con la opinión de Watson sobre el hecho del cerebro ser la mayor frontera biológica, pero el hecho de que contenga muchos billones de células y trillones de conexiones no torna su método primario necesariamente complejo, caso logremos identificar patrones fácilmente comprensibles (y recreables) en esas células y conexiones, especialmente aquellas macizamente redundantes. […] Así como una diversidad espantosa de organismos proviene de las diferentes combinaciones de valores del código genético encontrado en el ADN nuclear y mitocondrial, una fantástica variedad de ideas, pensamientos y habilidades se forman en base de los valores de patrones (de conexiones y fuerzas sinápticas) encontrados en nuestros identificadores de patrones neocorticales y entre ellos”.[49]

Esa proposición expresa muy bien esa ontología monista que cree encontrar en patrones simples la base de toda complejidad existente. No por casualidad ella viene acompañada de lo que se denominó “el dogma central de la biología molecular”, o sea, la postulación de que toda información se encuentra en el ADN que, unidireccionalmente, les transmite a las proteínas por medio del ARN. Una vez más, en el polo opuesto de esa teoría del cerebro de patrones, está la teoría de Nicolelis y Cicurel del Cerebro Relativístico. “De un modo general, la teoría del cerebro relativístico propone que la existencia de un componente analógico cerebral, y suya interacción recursiva con elementos digitales del sistema nervioso, representada por las redes neuronales, proviene el mecanismo neurofisiológico que nos permite anticipar, abstraer y adaptar rápidamente a los eventos del mundo exterior”.[50] El término “relativístico” describe justamente esa “interacción recursiva” del cerebro que tiene la pluralidad de su totalidad material compleja como punto de vista de sus operaciones, y no un sistema de patrones previamente estructurados o codificados. La teoría del cerebro relativístico postula justamente que, el cerebro es un sistema de información incorporada que integra en sus niveles de funcionamiento las dimensiones del software y del hardware.

“El cerebro tiene que ser considerado como un ‘sistema integrado’, un ‘continuum’ único que procesa información como un todo, en el cual ni “software”, ni “hardware” y incluso mismo una memoria no puede ser descripta de modo distinto al del procesamiento intrínseco del sistema. Al contrario, en nuestra visión, la forma por la cual el cerebro representa información es íntimamente relacionada con el funcionamiento de sus varios niveles de organización física, de su macroestructura global, hasta el nivel cuántico”.[51]

De este modo, el sistema híbrido analógico-digital que los autores proponen como descripción del cerebro no reduce las conectividades neurales a patrones simples, sino que los comprende como un proceso complejo de individuación que se amplifica en las nuevas conectividades auto-adaptables y plásticas que integran el sistema nervioso.[52] Finalmente, para los autores, el cerebro puede ser comprendido como una máquina de computación, pero que procesa la información como materialidad propia de su estructura física. “Un cerebro computa, pero la realización de esa computación está íntimamente ligada a su estructura física y no necesariamente está basada en alguna forma de lógica binaria neural”.[53] Si hay una simbiosis o un hibridismo posible entre la máquina y el cerebro, ese puede alejarse de la reducción del cerebro a los patrones de la máquina digital y aproximarse de las interfaces de las máquinas analógico-digitales.

Los límites de hibridismo cerebro-máquina al cerebro como sistema híbrido analógico-digital

Finalmente, como una especie de conclusión, nos gustaría proponer una síntesis muy breve de los caminos que se tienen dibujados para la hibridización cerebro-máquina que está en curso en nuestro presente. Como dijimos al comienzo, no se trataba de un ensayo para salvar el cerebro humano de su —cada vez mayor— conectividad con las máquinas digitales. Los aparatos digitales como los smartphones y los avatares de virtualidad del “yo” que son los perfiles de las redes sociales, así como la omnipresencia de la conectividad en las aplicaciones, tienden a ponernos inexorablemente frente a una ciberexistencia que mezcla la realidad digital con la realidad analógica. Nuestros cerebros viven en medio de esa individuación analógico-digital.

En esa individuación se encuentra, por un lado, como ilustramos aquí, el camino por el pensamiento de la reducción del cerebro y del pensamiento de Ray Kurzweil, a un tipo uniforme de relación entre procesos que se refiere a las máquinas digitales. No por casualidad, así como Shannon había encontrado una unidad básica de información ―que nombró de bits― y algunos científicos creían haber encontrado la unidad básica de la vida en el gen, Kurzweil creyó encontrar lo que él nombro como “módulos” del neocórtex, la unidad básica de reconocimiento ―por medio de la redundancia― de patrones neuronales. “Creo que la unidad básica es un identificador de patrones y que este constituye el componente fundamental del neocórtex”.[54] El capítulo “Un modelo del neocórtex: la teoría de la mente basada en reconocimiento de patrones” del libro Cómo crear una mente (2014) es básicamente una transposición del modo en el que Shannon organizó en la Teoría Matemática de Información (TMI) y las unidades mínimas de información (bits) para la manera en que los axones producen e identifican patrones ―no por casualidad, es la redundancia lo que, en ambos casos, mueve el dispositivo de uniformización―. Por otro lado, se encuentra el camino ilustrado por Nicolelis y Cicurel que pretenden ampliar la compresión del cerebro como un pluralizador y complejificador de relaciones. No por otra razón ellos proponen que “[…] solamente la dinámica intrínseca del sistema recursivo analógico-digital, que define el continuum espaciotemporal del cerebro, es realmente relevante para el procesamiento de información por el sistema nervioso”.[55] Ese sistema híbrido analógico-digital que los autores proponen como descripción para la individuación del cerebro, es una máquina abierta a las nuevas organizaciones vitales e informacionales de los seres humanos.

Así, al final, lo que está en cuestión no es solo una discusión filosófica, epistemológica u ontológica que implicaría el desarrollo de la neurociencia contemporánea, sino la propia cuestión ético-política de si queremos encerrar nuestros modos de vida en la uniformización creciente de la máquina digital o abrirnos a una hibridización que hace devenir nuestros cerebros y cuerpos.

Bibliografía

- Bardin, A., Epistemology and Political Philosophy in Gilbert Simondon — Individuation, Technics, Social Systems, London, Springer, 2015.

- Barthélémy, J-H., “Glossary: Fifty Key Terms in The Works of Gilbert Simondon” en De Boever A. et al. (eds.) Gilbert Simondon: being and technology, Cheshire, Edinburgh University Press, 2012.

- Benasayag, M., El cerebro aumentado, el hombre disminuido, Buenos Aires, Paidós, 2015.

- Blanco J., Rodríguez P., “Sobre la fuerza y la actualidad de la teoria simondoniana de la información” en Blanco J. et al. (coords.) Amar a las máquinas — cultura y técnica en Gilbert Simondon, Buenos Aires, Prometeo Libros, 2015.

- Christian, B., O Humano mais humano- o que a inteligencia artifical nos ensina sobre a vida, São Paulo, Companhia das Letras, 2013.

- Combes, M., Gilbert Simondon and the Philosophy of the Transindividual, Cambridge, The MIT Press Massachusetts, 2013.

- Gleick, J., A informação — uma história, uma teoria, uma enxurrada, São Paulo, Companhia das Letras, 2013.

- Isaacson, W., Os inovadores — uma biografia da revolução digital, São Paulo, Companhia das Letras, 2014.

- Kurzweil, R., Como criar uma mente — os segredos do pensamento humano, São Paulo, Aleph, 2014.

- _______, A era das máquinas espirituais, São Paulo, Aleph, 2007.

- Negroponte, N., A vida digital, São Paulo, Companhia das Letras, 1995.

- Nicolelis, M., Muito além do nosso eu — a nova neurociência que une cérebro e máquinas e como ela pode mudar nossas vidas, São Paulo, Companhia das Letras, 2011.

- Nicolelis, M; Cicurel, R., O cérebro relativístico, São Paulo, Kios Press, 2015.

- Rodríguez, P., “Extrálogo” en Tiqqun, cibernética, Buenos Aires, Hekht Libros, 2015.

- _______, Historia de la información: del nacimiento de la estadística y la matemática moderna a los medios masivos y las comunidades virtuales, Buenos Aires, Capital Intelectual, 2012.

- Ruyer, R., A cibernética e a origem da informação, Rio de Janeiro, Paz e Terra, 1972.

- Sadin, E., La humanidad aumentada — La administración digital del mundo, Buenos Aires, Caja Negra Editora, 2017.

- Schmidt, E., Cohen, J., A Nova Era Digital, Rio de Janeiro, Intrínseca, 2013.

- Simondon, G., La individuación a la luz de las nociones de forma e información, Buenos Aires, Ediciones La Cebra y Editorial Cactus, 2009.

- _______, El modo de existencia de los objetos técnicos, Buenos Aires, Prometeo Libros, 2007.

- _______, Sobre la técnica, Buenos Aires, Cactus, 2017.

- _______, Comunicación e información — cursos y conferencias, Buenos Aires, Cactus, 2015.

- Tiqqun, La hipótesis cibernética, Buenos Aires, Hekht Libros, 2015.

- Vilalta, L., A criação do devir — ética e ontogênese na filosofia de Gilbert Simondon. Dissertação defendida em 2017 pela Faculdade de Filosofia, Letras e Ciências Humanas da Universidade de São Paulo. Disponível em: http://www.teses.usp.br/teses/disponiveis/8/8133/tde-11042018-160953/pt-br.php.

- VV. AA., El concepto de información en la ciencia contemporánea — Colóquios de Royaumont, México, Siglo XXI, 1966.

- Wiener, N., Cibernética e sociedade — O uso humano de seres humanos, São Paulo, Cultrix, s.d.

Notas

[1] Simondon, La individuación a la luz de las nociones de forma e información, ed. cit., p.475.

[2] Benasayag, El cerebro aumentado, el hombre disminuido, ed. cit., p. 21.

[3] Christian, O Humano mais humano- o que a inteligencia artifical nos ensina sobre a vida, ed. cit., p. 26.

[4] Gleick, A informação — uma história, uma teoria, uma enxurrada, ed. cit., p. 125.

[5] Ibid., p. 219.

[6] Rodríguez, Historia de la información: del nacimiento de la estadística y la matemática moderna a los medios masivos y las comunidades virtuales, ed. cit., p. 28.

[7] Una buena historia de la personas, instituciones e invenciones que hicieron posible las computadoras actuales y las redes de Internet puede ser encontrada en Isaacson, W. Os inovadores — uma biografia da revolução digital, ed. cit.

[8] Rodríguez, op. cit., p. 15.

[9] Tiqqun, La hipótesis cibernética, p. 40.

[10] La descripción del Sistema X verificado por Shannon, es muy aclaradora en sus relaciones entre criptografía, información y sistemas de comunicación, pues “su funcionamiento consistía en recoger muestras del señal analógico de la voz en el ritmo de cincuenta veces por segundo —‘cuantificándolo’ o ‘digitalizándolo’— y, así, enmascarándolas por medio de la aplicación de una clave aleatoria que, azarosamente, era muy parecida al ruido en los circuitos, con el cual, los ingenieros estaban ya familiarizados. Shannon no diseñó el sistema —él fue designado para su análisis desde el punto de vista teórico, lo que se esperaba para probar su calidad indescifrable—.” Gleick, A informação — uma história, uma teoria, uma enxurrada, ed. cit., p. 213.

[11] Rodríguez, op. cit., pp. 33-34.

[12] Isaacson, op. cit., p. 59. Es importante aclarar que el bit como unidad de información es definido por medio de la mensuración de la cantidad de información en un sistema. Ésta, calculada probabilísticamente, es la que establece para Shannon el bit como el patrón digital para la codificación y programación de los sistemas. “La TMI considera que la cantidad de información se define como la suma del logaritmo de las probabilidades de aparición de los diferentes símbolos. En su artículo, Shannon denominó significativamente entropía a esa cantidad de información. Medir matemáticamente la información es medir la incertidumbre asociada al producto de una fuente de mensajes. Por lo tanto, el concepto de información no se aplica a los mensajes individuales, sino a todas las señales emitidas por una fuente. Dicho de otro modo, son las propiedades estadísticas de la fuente las que marcan cuánta información hay en un conjunto de mensajes” Rodríguez, op. cit., p. 33.

[13] Wierner, Cibernética e sociedade — O uso humano de seres humanos, ed. cit., p. 15.

[14] Tiqqun, op. cit., p. 31.

[15] Wierner, op. cit., p. 16.

[16] Rodríguez, op. cit., p. 39.

[17] Gleick, op. cit., p. 16-17.

[18] Barthélémy, “Glossary: Fifty Key Terms in The Works of Gilbert Simondon”, ed. cit., p. 214.

[19] Vilalta, A criação do devir — ética e ontogênese na filosofia de Gilbert Simondon, ed. cit., p. 46.

[20] Ibid., p. 57.

[21] Simondon, Comunicación e información — cursos y conferencias, ed. cit., p. 139.

[22] Blanco y Rodríguez, “Sobre la fuerza y la actualidad de la teoría simondoniana de la información”, ed. cit., pp. 98-99.

[23] El paradigma cibernético, como lo analizó Andrea Bardin, propone que “[…] el código del Emisor y Receptor deben coincidir para que el intercambio de información ocurra correctamente”. Epistemology and Political Philosophy in Gilbert Simondon — Individuation, Technics, Social Systems, ed. cit., p. 26.

Así, el dispositivo central de control de los procesos de la cibernética consiste en la postulación de un principio de eficacia único y uniformizador en las operaciones informacionales, para la organización estable del sistema de comunicación entre los seres. “Para Simondon, el orden dinámico depende de la transmisión de las señales expresadas por el código para el funcionamiento normal del sistema, mientras que la eficacia dice respecto al impacto desorganizador de la nueva información en el mismo funcionamiento. Ellos son dos procesos radicalmente distintos que no deben ser confundidos; el primero determinista y el segundo parcialmente aleatorio. Al revés, por identificar señal e información, la cibernética ha reducido el intercambio de informaciones a un único proceso determinista que mantiene la identidad de los sistemas involucrados sustancialmente intocada, reduciéndolos a subconjuntos del macrosistema, al cual, se supone que sea enteramente dependientes” (Bardin, op. cit., p. 27). La eficacia del principio cibernético estaría, entonces, en el control del grado de entropía del sistema por medio de la cuantificación de la información, de la uniformización de los procesos codificados y de la determinación del ruido o de la diferencia que una nueva información, puede generar en ese sistema.

[24] Vilalta, op. cit., p. 50.

[25] Blanco y Rodríguez, op. cit., p. 100. Blanco y Rodríguez mostraron como, ya en las décadas posteriores al aparecimiento de la cibernética, una línea de autores como Gregory Bateson y Donald McKay ―y podríamos agregar también a Raymond Ruyer― comprendieron ese potencial de la cibernética para captar la información como “una diferencia que hace una diferencia”, teniendo el propio Ross Ashby, en su libro Introducción a la cibernética, señalado la diferencia como su concepto central (2015, p. 111).

[26] Vilalta, op. cit., p. 52. “Existen así dos aspectos de la información que se distinguen técnicamente por las condiciones opuestas que necesitan en la transmisión. En un sentido, la información es lo que aporta una serie de estados imprevisibles, nuevos, que no forman parte de ninguna serie definible de antemano; es entonces lo que exige del canal de información una disponibilidad absoluta en relación con todos los aspectos de la modulación que dirige; el canal de información no debe aportar por sí mismo ninguna forma predeterminada, no debe ser selectivo […] En ese sentido, la información tiene ciertos caracteres comunes con los fenómenos puramente contingentes, sin ley, como los movimientos de agitación térmica molecular, la emisión radioactiva, la emisión electrónica discontinua en el efecto termoelectrónico o fotoeléctrico. […] En un sentido inverso, la información se distingue del ruido porque se le puede asignar un cierto código, una uniformización relativa a la información […] Esta oposición representa una antinomia técnica que plantea un problema al pensamiento filosófico: la información es como el acontecimiento del azar, pero, sin embargo, se distingue de él”. Simondon, El modo de existencia de los objetos técnicos, ed. cit., pp. 152-153.

[27] “La adquisición de forma o la recepción correcta de un mensaje serían entonces procesos que constan de un principio y un fin que al ser alcanzado confirman que hay información en el sistema. Aquí es donde Simondon propone una salida, un punto de fuga, al equilibrio estable de ambas concepciones […] El punto de anclaje de su teoría es la metaestabilidad de las posiciones ‘pasivas’ y por lo tanto su transformación en activas; es más, es de ellas quien depende el proceso entero de la información. Lo que define la correcta recepción de la información como adquisición de forma o llegada de un mensaje es el hecho de que quienes reciban tengan capacidad de transformarse, y de este modo logra hacer equivaler a la información con la ontogénesis y con la individuación misma” (Blanco y Rodríguez, op. cit., p. 99.

[28] Vilalta, op. cit., p. 58.

[29] Nicolelis y Cicurel, O cérebro relativístico, ed. cit., p. 11 e 83.

[30] Simondon, Sobre la técnica, ed. cit., p. 287.

[31] Idem.

[32] Ibid., p. 289.

[33] Idem.

[34] Nicolelis y Cicurel, op. cit., p. 12.

[35] Kurzweil, Como criar uma mente — os segredos do pensamento humano, ed. cit., p. 222.

[36] Idem.

[37] Ibid., p. 228.

[38] Ibid., p. 237.

[39] Idem.

[40] Gleick, op. cit., pp. 271-272.

[41] Nicolelis y Cicurel, op. cit., pp. 81-84.

[42] Blanco y Rodríguez, op. cit., p. 97.

[43] Nicolelis y Cicurel, op. cit., p. 82.

[44] Ibid., p. 65.

[45] Rodríguez, op. cit., p. 128-129.

[46] Ibid., p. 130.

[47] Idem.

[48] Ibid., p. 131.

[49] Kurzweil, op. cit., pp. 22-23.

[50] Nicolelis y Cicurel, op. cit., p. 93.

[51] Ibid., p. 56.

[52] Ibid., p. 69.

[53] Ibid., p. 96.

[54] Kurzweil, op. cit., p. 56.

[55] Nicolelis y Cicurel, op. cit., p. 96.

Leave a Reply

You must be logged in to post a comment.