ISAAC ASIMOV

Resumen

En el presente trabajo se pretende dar un vistazo a las ideas de Isaac Asimov (1920-1992) sobre la posible interacción futura entre humanos y máquinas con inteligencia artificial, Tales seres, al igual que los humanos, serán provistos de algún sentido de moralidad que, aunque rudimentario, podría llevarlos a comprenderse a sí mismos como seres libres y casi humanos. A continuación, veremos cómo principios programados en los robots pueden llevar a un conflicto interno en la toma de decisiones, cómo tales principios podrían comenzar a ser interpretados, y cómo una nueva interpretación puede gestar nuevas subjetividades que incluso refuerzan un vínculo de origen con la humanidad.

Palabras clave: Asimov, leyes, robótica, libertad, posthumanidad.

Abstract

Isaac Asimov propose trough his stories the three laws of robotics, which could rule the behavior of artificial machines that must protect and obey the man. Just as it happens in humans, robots will have conflicts of value, although irresoluble in a complex level for they limited brains. Such behavior lead trough values have the intention of leading the robots, so that they don’t get out of their “right behavior”, which implies obey the man laws. Just in some specific cases interpretations begin to give up that lead even over the initial laws, just particular individuals could achieve to overcome such limitations. But although it looks for to free the clamping of this laws, this, enrolled in themselves, lead them to identify with their creators, wishing to even achieve human condition.

Keywords: Asimov, laws, robotics, freedom, posthumanity.

Isaac Asimov publicó por primera vez en 1942 el cuento Sentido giratorio o El círculo vicioso, el cual expondrá las tres leyes de la robótica, contempladas posteriormente en el cine, la ciencia ficción o como un precedente para una ética de los robots, mucho antes de que la inteligencia artificial (IA), como hoy la conocemos, pudiera tan siquiera imaginarse. Dichas leyes las recuerda Gregory Powell a su compañero Mike Donovan, mientras reflexionan sobre el extraño comportamiento del robot SPD-13 (o Speedy, como lo llamaban) que los acompañaba en su misión a Mercurio y que posiblemente había sufrido una confusión al seguir las directivas:

“—[…] las tres Reglas Fundamentales Robóticas, las tres reglas que han penetrado más profundamente en el cerebro positrónico de los robots. —Sus enguantados dedos fueron marcando los puntos en la oscuridad—. Tenemos: Primera. ‘Un robot no debe dañar a un ser humano, ni, por su inacción, dejar que un ser humano sufra daño’. […] —Segunda —continuó Powell—. ‘Un robot debe obedecer las órdenes que le son dadas por un ser humano, excepto cuando estas órdenes están en oposición con la Primera Ley’. […] —Y la tercera: ‘Un robot debe proteger su propia existencia hasta donde esta protección no esté en conflicto con la Primera y Segunda Leyes’”.[1]

Pero veamos el contexto de la historia para poder comprender más acertadamente las leyes de la robótica y el conflicto ético en el que se puede caer al momento de que dichas leyes se enfrentan.

La historia de sentido giratorio se desenvuelve en el año 2016, cuando Powell, Donovan y el robot SPD-13 (Speedy) viajan al planeta Mercurio para poner de nuevo en funcionamiento una estación minera que fue abandonada una década atrás. Descubren que los bancos de proto-células que proveen vida a la base tienen poco selenio y pronto morirán. El pozo de selenio más cercano está a varios kilómetros y le encomiendan a su robot la misión de conseguirlo.

Ante la preocupación de los astronautas por la demora de Speedy, que fue mandado hace algunas horas para localizar pozos de selenio, comienzan a gestarse iniciativas para recobrar el robot, pues era el único de los que poseían, dado su avanzado modelo, que podía aguantar las altas temperaturas del planeta sin que éstas alcanzaran a corroer sus circuitos o articulaciones, el único, además, que podía localizar fácilmente los yacimientos de combustible. Lo cierto es que, si el robot no volvía, no habría selenio y, por lo tanto, sin energía, ni una barrera ante las altas temperaturas, tarde o temprano les llegaría la muerte.

Están seguros de que los trajes protectores no aguantan la luz directa del sol, así que no son una opción para buscar al robot, sin embargo, tienen seis robots de la primera expedición. Entonces les colocan la batería atómica a dos de ellos y los envían en busca de Speedy para que le ordenen que regrese y, si es necesario, que lo traigan a la fuerza, pues era necesario repararlo para continuar con la misión. Sin embargo, no es tan fácil volver a utilizar los robots de la primera misión en Mercurio, tienen que montarlos como a caballos, cosa que era necesaria años atrás para poder controlar a los robots. Parten entonces por caminos subterráneos de algunas antiguas minas que podían conducirlos, evitando los rayos solares, a las proximidades de donde se encontraba el robot perdido.

ILUSTRACIÓN PARA LA HISTORIA “SENTIDO GIRATORIO” DE ISAAC ASIMOV (1942)

Mientras recorren el camino, los astronautas se preguntan qué pudo pasarle a Speedy si estaba adaptado para soportar altas temperaturas y era a prueba de averías, aunque más adelante se darán cuenta que podría tratarse de un error en las órdenes que le dieron.

Finalmente, después de un largo tiempo pudieron divisar a lo lejos al robot SPD13 (o Speedy). Sin embargo, aunque lo llaman insistentemente, éste responde unas palabras incomprensibles que hacen evidente la falla en su programación, en cierta manera parece borracho en el sentido humano, pues las duras condiciones atmosféricas y el conflicto de reglas lo habían lastimado. Esto los confunde por un momento, pero saben que sólo bastaba con enterarse del problema para poder corregirlo y seguir con la misión.

KULDAR LEEMENT, “KOLM v2”

Es así que Greg Powell, tratando de localizar problemas en su programación, interpela a su amigo Mike Donovan, preguntándole las palabras exactas que le dijo al robot SPD13 cuando lo mandó a buscar selenio, y esas fueron: “Speedy, necesitamos selenio, puedes encontrarlo en el sitio, ve por él”.[2] Es así que Powell se dio cuenta de que su compañero no le dio una orden exacta, ni le señaló la urgencia con que necesitaban el combustible para sobrevivir a las altas temperaturas del planeta.

En ese momento comienzan a reflexionar sobre las tres leyes fundamentales de la robótica y sobre cómo cualquier contradicción entre algunas de estas leyes pudo llegar a dañar la programación de Speedy, alterando los diferentes potenciales positrónicos de su cerebro. Recordemos que las leyes de la robótica se presentan del siguiente modo:

Primera ley: no dañar a un ser humano, por acción u omisión.

Segunda ley: obedecer órdenes humanas que no vayan en contra de la primera ley.

Tercera ley: proteger su propia existencia sin estar en conflicto con la primera y segunda leyes.

De esta manera, si

“[…] un robot se encuentra en peligro y lo sabe. El potencial automático que establece la Tercera Ley le obliga a dar la vuelta. Pero supongamos que tú le ‘ordenas’ [Powell dirigiéndose a Donovan] correr este peligro. En este caso la Segunda Ley establece un contrapotencial más alto que el anterior y el robot cumple la orden a riesgo de su existencia”.[3]

PHILIPPE CAZA, “GANDAHAR” (1987)

El caso de Speedy no es diferente, aunque sea un modelo especializado para aquellas misiones, la tercera ley ha sido reforzada en la programación de los modelos SPD, de tal modo que huyen ante la amenaza eminente a su propia existencia. Sin embargo, dada una orden vaga y sin énfasis especial, es llevado al potencial de la segunda ley de forma débil. Los astronautas concluyen que el pozo de selenio representa un peligro que efectivamente aumenta al acercarse a él (ya que la exposición prolongada a gases corrosivos cerca del pozo de selenio puede dañar su sistema), y a cierta distancia el potencial de la tercera ley, que lo lleva a preservar su propia existencia, que es muy alto; compensa el potencial de la segunda ley, obedecer órdenes humanas, que en este caso es impreciso y por lo tanto muy bajo, lo cual crea un equilibrio. Es por esto que por una ley retrocede y por la otra sigue adelante, dibujando de este modo círculos concéntricos alrededor del pozo de selenio, justamente a la distancia donde los potenciales de la segunda y la tercera ley se equilibran. Tienen que corregir el error de algún modo para sacarlo del círculo, pues en equilibrio potencial y conflicto entre leyes, la mitad de su cerebro positrónico está perdido, al igual que parte de su voluntad, de ahí que parezca un borracho que no sabe a dónde va.

KAZUAKI IWASAKI, “LA GALAXIA” (1981)

El dilema de los astronautas es, entonces, que no pueden conseguir el selenio por ellos mismos, dadas las altas temperaturas; no pueden mandar a los robots de montura porque no pueden ir solos, ni los pueden llevar tan rápido para evitar quemaduras solares, ni siquiera sacrificarse yendo uno para salvar al otro, ya que los robots de montura necesitan órdenes de ida y de vuelta. Por otra parte, no pueden agarrar a Speedy porque cree que están jugando y huye, dada la disfuncionalidad temporal en su cerebro positrónico.

Además de esto, la acción corrosiva del monóxido de carbono en la atmósfera puede haber afectado a Speedy de forma grave, ya que ha estado expuesto a dichos gases por varias horas, lo cual puede acarrear un daño irreparable a sus articulaciones y le impediría regresar a la base, por eso deben apresurarse.

KULDER LEEMENT, “EZONOVA” (2012)

Concluyen entonces que, ya que no se puede incrementar el potencial de la segunda ley dando las órdenes, pueden hacer lo contrario, es decir, si incrementan el peligro, dicho peligro incrementará el potencial de la tercera ley y retrocedería hasta el lugar donde están los astronautas. De esta manera, incrementarán el monóxido de carbono cerca de donde él se encuentra para sacarlo del círculo vicioso en el que ha quedado encerrado. Para lograr su cometido, hacen que un robot-montura lance a gran distancia una sustancia que se esparce como polvo cerca de Speedy, en ese mismo momento el robot corre hacia los humanos, pero de nuevo regresa lentamente hacia donde estaba; y aunque le ordenan a otro robot que lo atrape aquél ya va demasiado lejos.

Así, Powell y Donovan se dan cuenta que simplemente estaban estableciendo nuevos equilibrios cuando lanzaban algún químico para crear mayor cantidad de monóxido de carbono e incrementaban el potencial de la tercera ley, pues el robot retrocede su posición hasta que la sustancia desaparece y los niveles atmosféricos se restablecen, entra en equilibrio y luego regresa, es decir, de algún modo están inventando otra órbita temporal en el círculo. Así comprendieron que, sin importar cómo traten de modificar los potenciales de la tercera o la segunda ley, sólo conseguirían cambiar momentáneamente su equilibrio.

BRUCE PENNINGTON, “COSTA ESTE” (1989)

Para poder recuperar al robot, sobrevivir y continuar con la misión en Mercurio que deben salirse inclusive de la segunda y tercera ley, recurriendo a la primera. Desesperados plantean otra estrategia “De acuerdo con la Primera Ley, un robot no puede ver a un ser humano en peligro por culpa de su inacción. La Segunda y la Tercera no pueden alzarse contra ella”[4], esto, aunque el robot esté descontrolado y confundido. De esta manera ponen a prueba la primera ley, no dañar a un ser humano, por acción u omisión, para tratar de romper el equilibrio que lo confina en el círculo. Es más,

“[…] no podrá jamás dar una solución a un problema que le haya sido sometido, si esta solución trae aparejada la muerte o daño de seres humanos. En cuanto a él hace referencia, un problema que no tuviese más que esta solución sería insoluble. Si este problema estuviese unido a una urgente demanda de respuesta, sería posible que el Cerebro, que es sólo un robot al fin y al cabo, se encontrase ante un dilema según el cual no podría ni contestar ni negarse a hacerlo”.[5]

Powell sale y aguanta el calor de la radiación, Speedy lo observa de lejos sin acercarse y, contrario a lo que se pensaba, comienza a retroceder, pero Powell lo interpela: “Speddy, debo regresar a la sombra o el sol terminará conmigo ¡es cuestión de vida o muerte, Speedy te necesito!”.[6] El robot sigue diciendo incoherencias.

Aparece en aquel momento uno de los antiguos robots-montura: “[…] perdón señor, no debo moverme sin alguien encima, pero estás en peligro”,[7] lo cual demuestra el peso de la primera ley en el cerebro positrónico de los robots. Pero Powell rechaza su ayuda y le ordena que se aparte para continuar con su estrategia de capturar a Speedy, pero esto no sucede, pues es imposible quitarse de encima al antiguo robot que sigue insistiendo, mientras Powell le ruega a Speedy que le ayude, pues se está muriendo por el calor.

PHILIPPE CAZA, “LE ROBOT QUI REVAIT” (1988)

Sin embargo, de tanto insistir, Powell logra que el robot SPD13 recapacite, manifestando que estaba confundido y que no comprendía lo que pasaba. Así, Powell le pide que lo lleve a la base mientras se desvanece en los brazos del robot. Al despertar, Donnovan había enviado al robot por selenio a otro pozo, aunque esta vez con órdenes precisas y él regresa en poco tiempo. Ahora Speedy se esconde de Powell, pues tiene miedo de acercársele ya que siente culpa por haberse fugado, pero Powell le da la mano y le dice que no fue su culpa.

Ley Cero

“Un robot no puede lastimar a la humanidad o, por falta de acción, permitir que la humanidad sufra daños”.[8]

Isaac Asimov hace responsables de la formulación de la Ley Cero a R. Daneel Olivaw y R. Giskard Reventlov, dos de sus robots más evolucionados, uno con apariencia humanoide y el otro, con la capacidad de leer la mente de las personas.

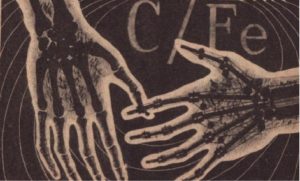

ILUSTRACIÓN PARA LA NOVELA DE ASIMOV “CUEVAS DE ACERO”

Danaeel y Giskard deben hacer frente al complot para destruir la Tierra por parte de Kelden Amadiro y Levular Mandamus, los cuales quieren aumentar la radioactividad del planeta para hacerlo inhabitable. En este sentido, para cumplir su misión, sabiendo que las tres leyes de la robótica le impiden actuar correctamente, Danaeel cree que debe existir una Ley Cero de la robótica que incluso modifique la primera ley, haciendo extensiva de esta manera la búsqueda del bienestar de toda la humanidad:

“Hay una ley que es superior a la primera ley. ‘Un robot no puede lastimar a la humanidad o, por falta de acción, permitir que la humanidad sufra daños.’ La considero ahora la ley Cero de la Robótica, La primera ley debería decir: ‘Un robot no debe dañar a un ser humano, o permitir, por inacción, que el ser humano sufra algún daño, a menos que tal acción viole la ley Cero de la Robótica’”.[9]

Giskard hace algunas objeciones a dicha ley, la principal es que la humanidad, comprendida claramente como una abstracción, ha servido como excusa a lo largo de la historia humana para muchas guerras y crímenes atroces, o en sus palabras:

“No puedo aceptar la ley Cero, amigo Daneel —respondió Giskard lentamente—. Sabes que he leído mucho sobre la historia humana. En ella he descubierto grandes crímenes cometidos por seres humanos y la excusa era siempre que estaban justificados por las necesidades de la tribu, del Estado o, incluso, de la humanidad una abstracción por lo que se la utiliza libremente para justificar cualquier cosa y, por tanto, tu ley Cero es inconveniente”.[10]

Según Giskard, aunque exista un peligro para la humanidad, los robots no pueden cimentar sus acciones desafiando las tres leyes originales, basándose en una suposición, aunque no niega que a través de sus estudios de “psicohistoria” trate de comprender la humanidad como un todo, con la esperanza de establecer algún día parámetros para predecir y guiar la historia humana. Pero eso es sólo una esperanza desde la que no puede, por su falta actual de comprobación, guiar la comunidad robótica, e incluso ni su propio comportamiento.

Vasilia Fastolfe, dueña humana de Giskard, interviene contra Danaeel al confirmar lo que su robot ha dicho:

“Entonces voy a explicarte algo, robot, y veremos si puedes sobrevivir a la explicación… Las tres leyes de la Robótica se refieren a seres humanos y robots individuales. Puedes indicarme un individuo o un robot individual. Pero ¿qué es tu ‘humanidad’ sino una abstracción? ¿Puedes mostrarme la humanidad? Puedes dañar, o no dañar, a un ser humano específico y comprender el daño o la falta del daño que ha ocurrido. ¿Puedes ver un daño hecho a la humanidad? ¿Puedes comprenderlo? ¿Puedes señalármelo?”.[11]

KULDAR LEEMENT, “SHAPE OR FORM” (2017)

Danaeel reconoció que era confuso para él y que no lo comprendía completamente, pero que seguía en pie y su cerebro aún no dejaba de funcionar por pensar una ley nueva. Vasilia lo reta entonces a que convenza a Giskard que siga su ley cero, y aunque lo intenta, éste se niega. Luego Vasilia interviene de nuevo contra Danaeel, insistiendo en el peligro que representa para los seres humanos un robot que al parecer funciona mal ya que desobedece las tres leyes, se trata de un peligro que debe ser eliminado. En sus palabras:

“Bien, robot, todos tus esfuerzos no han llegado a nada y, no obstante, sigues en pie. Eres curiosamente testarudo. Un robot como tú, que se atreve a denunciar las tres leyes y sigue funcionando, es un claro peligro para todos y cada uno de los seres humanos. Por esta razón creo que debes ser desactivado al instante. El caso es demasiado peligroso para esperar la lenta majestad de la ley, especialmente después de todo, por ser un robot y no el ser humano al que tratas de parecerte”.[12]

Al momento Vasilia llama a los robots que la acompañaban y les ordena que desmantelen a Danaeel, ellos dudan ante la apariencia muy similar a la humana que guarda su modelo, pero su dueña insiste y cuando se dirigen a capturarlo la mujer cae al suelo desmayada y los robots se detienen, Giskard había utilizado sus habilidades mentales para ayudar a su amigo, pero con ello había faltado a la primera ley.

En una conversación posterior el mismo Danaeel termina reconociendo, como lo señala Giskard, que podría dañar o permitir que se dañe a un individuo humano en nombre de la humanidad abstracta. Giskard sigue pensando que se requiere mayor claridad sobre el concepto “humanidad”, aunque su amigo le recuerda que ya ha aceptado la ley cero cuando inmovilizó los robots de Vasilia y borró su mente. A lo que responde Giskard:

“Cuando ordenó a los robots que te desmantelaran, amigo Daneel, y mostró placer ante esa idea, tu necesidad, sumada a lo que el concepto de ley Cero había hecho ya, dominó la segunda ley y rivalizó con la primera. Fue la combinación de la ley Cero, la psicohistoria, mi lealtad a Gladia y tu desamparo lo que dictó mi acción. […] El mencionar la ley Cero redujo la intensidad de la primera ley a un tono anormalmente bajo. La necesidad de salvarte fue suficiente para cancelar lo que quedaba de ella y yo…, bueno, actué como lo hice”.

Lo cierto es que Giskard interpretó el peligro de Danaeel, no como el peligro que corría un robot sino como el de un humano que debía proteger, olvidando la primera ley:

“—Lo curioso, amigo Daneel, es que no sé cómo ocurrió. Quizá fue que he observado que continúas pensando como un ser humano pero […] -En el momento en que los robots se acercaron a tí y Vasilia hizo gala de su placer salvaje, mis circuitos positrónicos se reformaron de modo anómalo. Por un momento, pensé en ti como en un ser humano y reaccioné de acuerdo a ello. (A lo que respondió Daneel) Creo que, si la situación fuera a la inversa, estoy casi seguro de que yo también haría lo mismo, que pensaría en ti como un ser humano”.[13]

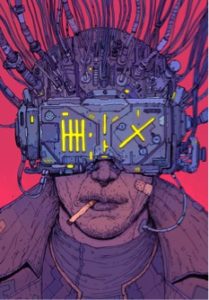

JOSAN GONZALEZ, BOOK COVER FOT THE BRAZILIAN EDITION OF “NEUROMANCER”

La Ley cero destruyó el cerebro positrónico de Giskard cuando intentó aplicarla ya que violó la primera ley de la robótica. R. Giskard murió en Robots e Imperio, tras verse obligado a dañar a un ser humano en virtud de la Ley Cero, violó a la vez la primera ley, lo cual dañó su cerebro positrónico. El problema. Fundamental con esta ley es definir “Humanidad”, así como determinar qué supone un “daño” para ésta. R. Daneel logró asimilarla gracias al sacrificio de Giskard, convirtiéndose desde entonces en el protector en la sombra de la humanidad.

Leyes de la robótica, un reflejo de la conducta humana

La doctora Susan Calvin, robopsicóloga comparte sus reflexiones en cierta ocasión con el doctor Alfred Lanning, experto en robótica y director de investigaciones de la U.S Robots., y con el político Francis Quinn, sobre cómo diferenciar a un robot de un humano . Para ella, aunque el cerebro positrónico no tiene manera de igualar la capacidad de elección autónoma de un humano promedio, las reglas que lo rigen y por las cuales trata de calcular sus opciones, son derivadas de valores que poseen sus propios creadores. Así:

“La naturaleza de la reacción robótica ante un dilema es impresionante -comenzó-. La psicología del robot está muy lejos de ser perfecta, como especialista puedo asegurárselo, pero puede ser discutida en términos cualitativos, porque a pesar de todas las complicaciones introducidas en el cerebro positrónico de un robot, está construido por los humanos, y por lo tanto, conformado de acuerdo con los valores humanos”.[14]

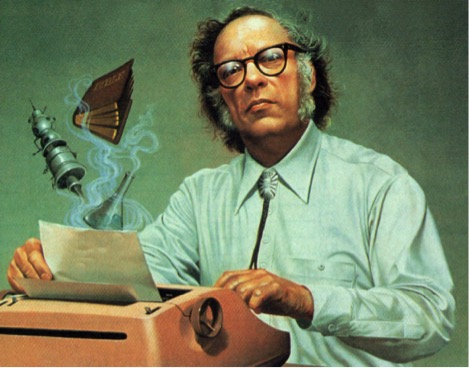

CHAPPIE (2015)

Hasta un humano puede emborracharse al negar su responsabilidad ante cierto problema que debe afrontar, ya sea por falta de conocimientos o porque no cree poseer la capacidad de realizar dicha elección. De forma similar sucede con un robot, que puede ir de una simple desorientación a una especie de locura que le impida seguir funcionando. En palabras de Calvin:

“Ahora bien, un humano enfrentado con una imposibilidad, responde frecuentemente con una retirada de la realidad; penetra en mundo de engaño, entregándose a la bebida, llegando al histerismo, o tirándose de un puente. Todo esto se reduce a lo mismo, la negativa o la incapacidad de enfrentarse serenamente con la situación. Y lo mismo ocurre con los robots. Un dilema, en el mejor de los casos, creará un desorden en sus conexiones; y en el peor abrasará su cerebro positrónico sin reparación posible”.[15]

Para Asimov (1984), habría estrictamente dos modos definitivos de distinguir a un robot humanoide de un humano, uno físico y otro psicológico. El primero implica un desmantelamiento o una disección que desintegrara al ente en cuestión hasta sus mínimos componentes, sometiendo éstos inclusive a rayos X para diferenciarlo. El segundo, requiere un estudio de la conducta, ya que es evidente que si se trata de un robot, su cerebro positrónico debe seguir las tres leyes. Si el ser en cuestión infringe alguna de las leyes podríamos decir que no es un robot, pero si se adapta a las leyes tenemos un problema, ya que no habría manera de saber si se trata de un robot que sigue su programación y su deber con las leyes, o simplemente de una buena persona, en tanto que dichas leyes terminan siendo un compendio de principios éticos humanos. Aclara Calvin dirigiéndose a Quinn:

“Porque, si se detiene usted a estudiarlas, verá que las tres Leyes de Robótica no son más que los principios esenciales de una gran cantidad de sistemas éticos del mundo. Todo ser humano se supone dotado de un instinto de conservación. Es la Tercera Ley de la Robótica. Todo ser humano “bueno”, siendo la consecuencia social del sentido de responsabilidad, deberá someterse a la autoridad constituida; obedecer a su doctor, a su Gobierno, a su psiquiatra, a su compañero; incluso si son un obstáculo a su comodidad y seguridad. Es la Segunda Ley del Robotismo. Todo ser humano “bueno”, debe, además, amar a su prójimo como a sí mismo. Arriesgar su vida para salvar a los demás. Esta es la Primera Ley de la Robótica”.[16]

La doctora Calvin prefiere a los robots que a los verdaderos humanos, pues aquellos podrían bien ser Seres humanos ejemplares. Un robot, “[…] por su obligación con las Leyes de la Robótica sería incapaz de dañar a un ser humano, incapaz de tiranía, de corrupción, de estupidez, de prejuicio.” Su único defecto sería que puede fallar en un momento determinado en tanto que el cerebro positrónico que lo hace funcionar no puede adaptarse, al no contar con la intrincada complejidad del cerebro humano.

Condición característica de ser humano

EL HOMBRE BICENTENARIO (1999)

Si pudiéramos pensar en una condición o signo característico necesario para alcanzar la condición humana, podríamos referirnos concretamente a la experiencia del robot humanoide Andrew, descrita por Asimov en El Hombre Bicentenario (1976) y llevada al cine por Chris Columbus (1999). En dicha historia un robot humanoide destinado al acompañamiento casero comienza gradualmente a descubrir lo que podría llamarse una subjetividad que lo hace diferente de otros de su mismo modelo. De esta forma empieza a manifestar ciertas habilidades particulares y ampliar sus conocimientos sobre la cultura humana y las artes, lo cual despierta en él cierta sensación que lo lleva a comprender de alguna manera aquella característica primordial del ser humano, y que cada vez y con más intensidad desea conseguir para convertirse en uno. Para Andrew, es necesario autodeterminarse, elegir por sí mismo, más allá incluso de las leyes de la robótica, las que sin embargo obedece, pero que no ve como una camisa de fuerza para determinar su personalidad. Así, poder elegir el espectro de su comportamiento y las elecciones de vida que en adelante quiere tomar implica acceder a un derecho humano que hasta ese momento era incompatible con la robótica: el derecho a ser libre.

Andrew, estableció cierta relación similar a la amistad con su dueño, e incluso le pide en una ocasión que le reciba sus ahorros de su vida para comprar su libertad. En realidad lo que buscaba el robot era un simple formalismo, era simplemente ser llamado “libre”, aunque esto supusiera ser posiblemente despreciado por la sociedad y perder todo lo que había conseguido. Sin embargo para éste la libertad no tiene precio, y solamente la existencia de la posibilidad de obtenerla ya vale el riesgo de perder todo lo que posee.

EL HOMBRE BICENTENARIO (1999)

Para la ley no existe un precedente, hasta el momento sólo el ser humano podía gozar de libertad, pero a Andrew esto poco le importaba, sabía que si fuera declarado libre no cambiaría mayor cosa en su vida, aunque lo poco que hiciera lo haría con más alegría. Le parecía que sólo aquel que desea la libertad puede ser libre, así lo aseguró al juez. En principio es declarado entonces objeto libre, lo cual lo puso bajo la custodia de nuevo de su dueño, el cual estaba desconcertado por la decisión, aunque Andrew lo tranquilizase diciendo que como los humanos, que actúan según las leyes, él seguiría actuando según las tres leyes de la robótica que seguían vigentes en su cerebro positrónico.

Así inicia un largo proceso por el que Andrew comienza a independizarse de su dueño, aunque sigue pendiente de él hasta su muerte, pues sin él no habría llegado a ser libre. A pesar de que su petición de ser humano legalmente siguió siendo desconocida, continuó con su propósito al modificar su cuerpo para hacerlo progresivamente perecedero como cualquier humano, poniendo la muerte como frontera final que llega a todos por igual. Así, con un nuevo cuerpo tecno-orgánico, un cuerpo humanoide orgánico se había programado a sí mismo para dejar de funcionar al cumplir doscientos años, el mismo día de su posible reconocimiento como humano, pues para él tal reconocimiento era la meta de su libertad. Así lo narra Asimov:

“Fue extraño el modo en que ese último acto capturó la imaginación del mundo. Andrew no había logrado conmover a la gente con todos sus esfuerzos, pero había aceptado la muerte para ser humano, y ese sacrificio fue demasiado grande para que lo rechazaran. La ceremonia final se programó deliberadamente para el segundo centenario. El presidente mundial debía firmar el acta y darle carácter de ley, y la ceremonia se transmitiría por una red mundial de emisoras y se vería en el Estado de la Luna e incluso en la colonia marciana. Andrew iba en una silla de ruedas. Aún podía caminar, pero con gran esfuerzo. Ante los ojos de la humanidad, el presidente mundial dijo: —Hace cincuenta años, Andrew fue declarado el robot sesquicentenario. —hizo una pausa y añadió solemnemente—: Hoy, el Señor Martin es declarado el hombre bicentenario. Y Andrew, sonriendo, extendió la mano para estrechar la del presidente. Andrew yacía en el lecho. Sus pensamientos se disipaban. Intentaba agarrarse a ellos con desesperación. ¡Un hombre! ¡Era un hombre! Quería serlo hasta su último pensamiento. Quería disolverse, morir siendo hombre”.[17]

A manera de conclusión, podemos decir entonces que las tres leyes de la robótica, que definirían el comportamiento de las posibles máquinas con inteligencia artificial con las cuales podríamos interactuar en un futuro cada vez más próximo, nos adentran en toda una aventura, en todo un recorrido por el cual podemos pensar en la similitud de los conflictos “morales”, por así decirlo, que puedan tener seres artificiales de tipo humanoide respecto de los conflictos de cualquier ser humano. Inclusive, podríamos pensar en la posibilidad de una ley cero, que se ponga por encima de la primera ley (llevando a la desobediencia de las tres leyes impresas por los humanos), y que busque la protección de la vida humana particular, para reflexionar sobre la protección de una humanidad abstracta a favor de la cual cualquier medida podría ser válida y que, al mismo tiempo, podría, como vimos, reinterpretarse de tal modo que dicha protección pueda extenderse incluso a una colectividad robótica con características “morales” que difícilmente se distinguirían de las humanas. Es decir, comprendiendo la condición humana más allá de una apariencia de carne, en la forma de ser humano.

JOSAN GONZÁLEZ, “THE FIXER” (2016)

Porque, a fin de cuentas, cómo podríamos reconocer la diferencia entre un robot y un humano, cuando sería posible que ambos poseyeran características físicas y comportamientos muy similares, siendo incluso a veces algún robot mejor sujeto moral que cualquier persona de carne.

Hay una característica propia de la humanidad que, como presagió Asimov, es posible que se inscriba en el comportamiento de seres de inteligencia artificial y que finalmente termine evolucionando, ya sea mediante algún prototipo defectuoso, ya sea por un mal funcionamiento o por la dependencia exagerada de la asistencia robótica hacia los humanos, lo que puede llevar al perfeccionamiento último de la máquina o su alzamiento (es decir, por cualquier error no previsto que lleve a que la humanidad pierda el control), y ésta es la libertad. Pero por qué podría darse ese deseo de inscribir tales patrones de comportamiento cuasi humano en los robots, sino es por el simple deseo del ser humano de sentirse inmortal, de hallar a otro igual, aunque éste pueda convertirse en amenaza, pero que en el fondo es su legado para el mundo cuando el hombre sea presa de la extinción, es decir, una posthumanidad.

Bibliografía

- Asimov, Isaac, El Hombre Bicentenario, Santiago de Chile, Ediciones B, 1976.

- _______, Los robots y el imperio, Buenos Aires, Emecé, 1987.

- _______, Yo, robot, Barcelona, Edhasa, 1984.

- García Manrique, Ricardo, “Yo, robot, o las tribulaciones de un robot kantiano”, Revista de Bioética y Derecho, N 9 (2007).

Notas

[1] Asimov, Yo, robot, ed. cit., p. 43.

[2] ibíd., p. 42.

[3] ibíd., p. 43.

[4] ibíd., p. 48.

[5] ibíd., p. 146.

[6] ibíd., p. 50.

[7] ibíd.

[8] Asimov, Los robots y el imperio, ed. cit., p. 241.

[9] ibíd.

[10] Asimov, Los robots y el imperio, p. 241.

[11] ibíd., pp. 241-242.

[12] ibíd., p. 242.

[13] ibíd., p. 252.

[14] ibídem, p. 48.

[15] ibídem, p. 146.

[16] ibídem, p. 179.

[17] Asimov, El Hombre Bicentenario, ed. cit., pp. 40-41.

Leave a Reply

You must be logged in to post a comment.